Résumé de la publication

Le Big Data est un terme qui décrit des volumes de données volumineux et difficiles à gérer – à la fois structurés et non structurés – qui inondent les entreprises au quotidien. Mais ce n’est pas la quantité de données qui est importante. C’est ce que les organisations font avec les données qui compte. Les mégadonnées peuvent être analysées pour obtenir des informations qui conduisent à de meilleures décisions et à des mouvements commerciaux stratégiques.

Nous allons découvrir dans cet article comment mettre en place une architecture et comment exploiter les données, en analysant les différents outils avec leurs avantages et leurs inconvénients.

Objectifs de la publication

- Découvrir le concept de big data et ses origines

- En savoir plus sur les différentes caractéristiques du Big Data

- Analyse des différents types de stockages, des modèles de données, des magasins NoSQL

- Initiation à Python et R

- Définition d’un modèle de données et catégorisation des modèles de données

- Structures des modèles de données

- Modélisation de différents modèles de données

- Des exemples concret d’applications

1 Introduction au Big Data et à la gestion des données

Ce chapitre traite du concept de Big Data, de ses sources et de ses types. En outre, le chapitre se concentre sur l’établissement d’une base théorique sur la modélisation et la gestion des données. Les lecteurs vont mettre en place une plate-forme sur laquelle nous pourrons utiliser le Big Data. Les principaux sujets abordés dans ce chapitre sont résumés comme suit :

- Découvrir le concept de big data et ses origines

- En savoir plus sur les différentes caractéristiques du Big Data

- Discussion et exploration des différents défis de l’extraction de données volumineuses

- Familiarisez-vous avec la modélisation de données volumineuses et ses utilisations

- Comprendre ce qu’est la gestion de données volumineuses, son importance et ses implications

- Configurer une plateforme Big Data sur une machine locale

1.1 Le concept de Big Data

Les systèmes numériques sont progressivement liés à des activités réelles. En conséquence, une multitude de données sont enregistrées et communiquées par des systèmes d’information. Au cours des 50 dernières années, la croissance des systèmes d’information et de leurs capacités de capture, de conservation, de stockage, de partage, de transfert, d’analyse et de visualisation des données a augmenté de façon exponentielle. Outre ces avancées technologiques incroyables, les personnes et les organisations dépendent de plus en plus de dispositifs informatisés et de sources d’informations sur Internet. L’étude IDC Digital Universe réalisée en mai 2010 illustre la croissance spectaculaire des données. Cette étude a estimé que la quantité d’informations numériques (sur les ordinateurs personnels, les appareils photo numériques, les serveurs, les capteurs) stockées dépassait 1 zettaoctet et prévoyait que l’univers numérique passerait à 35 zettaoctets en 2010. L’étude IDC caractérise 35 zettabytes en pile de DVD atteignant la moitié de la distance jusqu’à Mars. C’est ce que nous appelons l’explosion de données.

Si l’on parle aujourd’hui de Big Data, il faudra parler demain de « Huge » Data. Selon une nouvelle étude IDC, le volume total de données stockées sur notre planète atteindre 175 Zo en 2025 soit 5,3 fois plus qu’aujourd’hui. La plupart des données stockées dans l’univers numérique sont très peu structurées et les organisations sont confrontées à des problèmes de capture, de conservation et d’analyse. L’une des tâches les plus difficiles pour les organisations d’aujourd’hui consiste à extraire des informations et de la valeur des données stockées dans leurs systèmes d’information. Ces données, qui sont très complexes et trop volumineuses pour être gérées par un SGBD traditionnel, sont appelées big data.

Le Big Data est un terme pour un groupe de jeux de données tellement massif et sophistiqué qu’il devient difficile de traiter à l’aide d’outils de gestion de base de données traditionnel ou d’une application de traitement moderne. Sur le marché récent, les tendances en matière de données se réfèrent à l’utilisation de l’analyse du comportement des utilisateurs, de l’analyse prédictive ou de différentes méthodes avancées d’analyse de données qui extraient de la valeur de cette nouvelle analyse de système de données.

Qu’il s’agisse de données quotidiennes, de données métiers ou de données de base, si elles représentent un volume énorme de données, qu’elles soient structurées ou non, les données sont pertinentes pour l’organisation. Cependant, ce ne sont pas uniquement les dimensions des données qui importent ; c’est la façon dont l’organisation les utilise pour extraire des informations plus profondes qui peuvent les amener à prendre de meilleures décisions commerciales et stratégiques. Ces données volumineuses peuvent être utilisées pour déterminer la qualité de la recherche, améliorer le flux de processus dans une organisation, prévenir une maladie particulière, relier des citations légales ou combattre des crimes. Les mégadonnées sont omniprésentes et peuvent être utilisées avec les outils appropriés pour les rendre plus efficaces pour l’analyse commerciale.

1.1.1 Informations intéressantes sur le Big Data

Certains faits intéressants liés au Big Data, à sa gestion et à son analyse, sont expliqués ici :

- Près de 91% des leaders mondiaux du marketing utilisent les données clients sous forme de données volumineuses pour prendre des décisions commerciales.

- Il est intéressant de noter que 90% des données mondiales totales ont été générées au cours des deux dernières années.

- 87% des personnes acceptent d’enregistrer et de distribuer les bonnes données. Il est important de mesurer efficacement le retour sur investissement (ROI) de leur propre entreprise.

- 86% des personnes sont disposées à payer davantage pour une expérience client exceptionnelle avec une marque.

- 75% des entreprises déclarent qu’elles augmenteront leurs investissements dans le Big Data au cours de la prochaine année.

- Environ 70% des mégadonnées sont créées par des individus, mais les entreprises sont soumises au stockage et au contrôle de 80% de celles-ci.

- 70% des entreprises reconnaissent que leurs efforts de marketing font l’objet d’une surveillance accrue.

1.1.2 Caractéristiques du Big Data

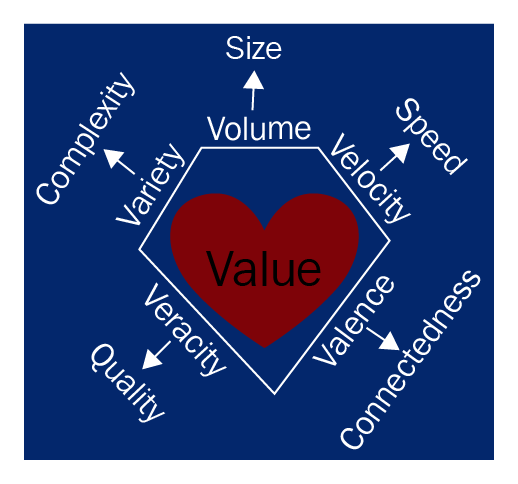

Nous avons exploré la popularité des données volumineuses dans la section précédente. Mais il est important de savoir quels types de données peuvent être catégorisés ou étiquetés comme des données volumineuses. Dans cette section, nous allons explorer diverses fonctionnalités du Big Data. La plupart des livres disponibles sur le marché prétendent qu’il existe six types différents, présentés comme suit :

- Volume : Le Big Data implique des quantités massives de données. La taille des données joue un rôle très important dans la détermination de la valeur des données. Il s’agit également d’un facteur clé qui permet de déterminer si nous pouvons juger la taille de la masse de données. Par conséquent, le volume justifie l’un des attributs importants du Big Data.

Remarque :

Chaque minute, 204 000 000 courriels sont envoyés, 200 000 photos sont téléchargées et 1 800 000 likes sont générés sur Facebook ; Sur YouTube, 1 300 000 vidéos sont visionnées et 72 heures de vidéo téléchargées.

L’idée derrière cette agrégation de volumes de données massifs est de comprendre que les entreprises et les organisations collectent et exploitent des volumes de données géants pour renforcer leurs produits, qu’il s’agisse de sécurité, de fiabilité, de soins de santé ou de gouvernance. En résumé, l’idée est de transformer ces données volumineuses en une forme d’avantage commercial.

- Vélocité : Elle se rapporte à la vitesse croissante à laquelle le big data est créé et à la vitesse croissante à laquelle les données sont stockées et analysées. Traiter les données en temps réel pour correspondre à leur vitesse de production à mesure qu’elles sont générées est un objectif remarquable de l’analyse de données volumineuses. Le terme vitesse s’applique généralement à la rapidité avec laquelle les données sont produites et traitées pour satisfaire les demandes ; il découvre le potentiel réel des données. Le flux de données est massif et continu. Les données peuvent être stockées et traitées de différentes manières, notamment le traitement par lots, le traitement en temps quasi réel, le traitement en temps réel et la diffusion en continu :

- Le traitement en temps réel fait référence à la possibilité de capturer, stocker et traiter les données en temps réel et de déclencher une action immédiate, permettant ainsi de sauver des vies.

- Le traitement par lots consiste à introduire une grande quantité de données dans de grandes machines et à les traiter plusieurs jours à la fois. C’est encore très courant aujourd’hui.

- Variété : il fait référence à de nombreuses sources et types de données, structurées, semi-structurées ou non structurées. Nous discuterons plus en détail de ces types de données volumineuses au chapitre 5, Structures de modèles de données. Lorsque nous pensons à la variété des données, nous pensons à la complexité supplémentaire résultant du nombre accru de types de données que nous devons stocker, traiter et combiner. Les données sont aujourd’hui plus hétérogènes, telles que les données d’image BLOB, les données d’entreprise, les données de réseau, les données vidéo, les données textuelles, les cartes géographiques, les données générées ou simulées par ordinateur et les données de médias sociaux. Nous pouvons classer la variété de données en plusieurs dimensions. Certaines des dimensions sont expliquées comme suit :

- Variété structurelle : il s’agit de la représentation des données. Par exemple, une image satellite des incendies de forêt de la NASA est complètement différente des tweets envoyés par des personnes qui voient le feu se propager.

- Variété de supports : les données sont livrées sur différents supports, tels que du texte, de l’audio ou de la vidéo. Celles-ci sont appelées variété de médias.

- Variété sémantique : La variété sémantique provient de différentes hypothèses de conditions sur les données. Par exemple, nous pouvons mesurer son âge en utilisant une approche qualitative (nourrisson, juvénile ou adulte) ou quantitative (chiffres).

- Véracité : Elle fait référence à la qualité des données et est également désignée comme validité ou volatilité. Les mégadonnées peuvent être bruyantes et incertaines, pleines de biais et d’anomalies et peuvent être imprécises. L’idée que les données n’ont aucune valeur si elles ne sont pas exactes (les résultats de l’analyse de données massives n’ont que la même qualité que les données analysées) crée des difficultés pour le suivi de la qualité des données – ce qui a été capturé, l’origine des données, et comment elles ont été analysées avant son utilisation.

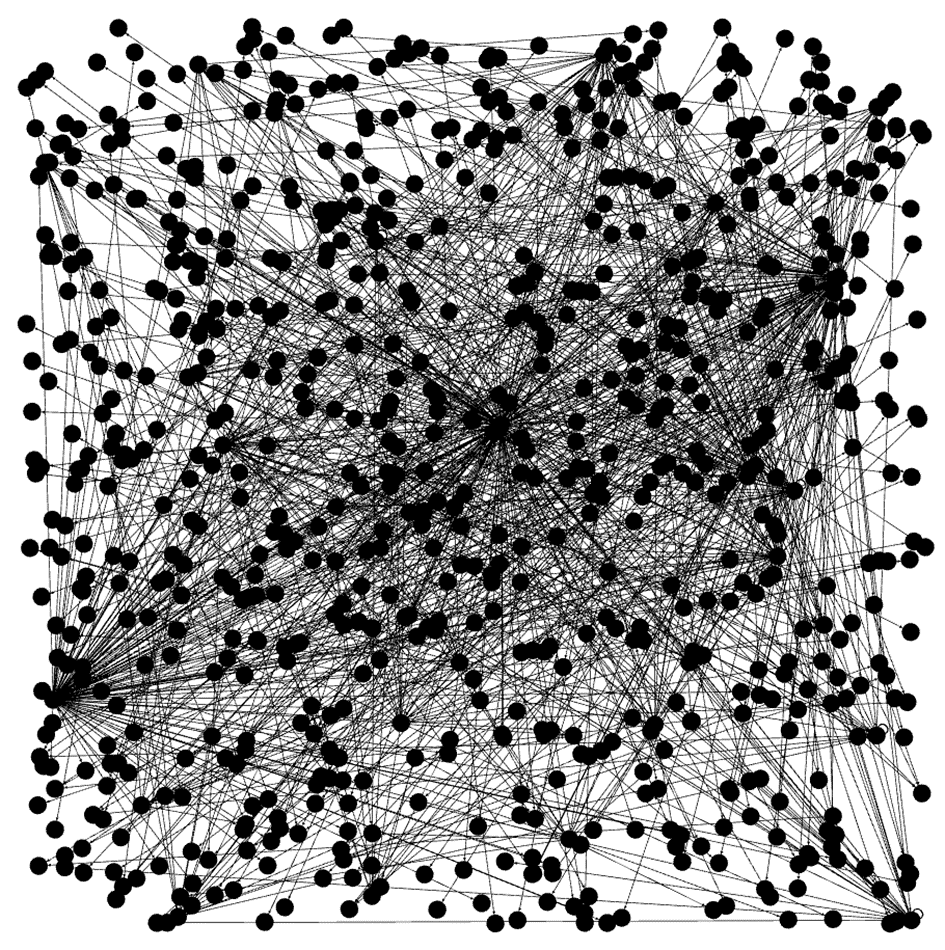

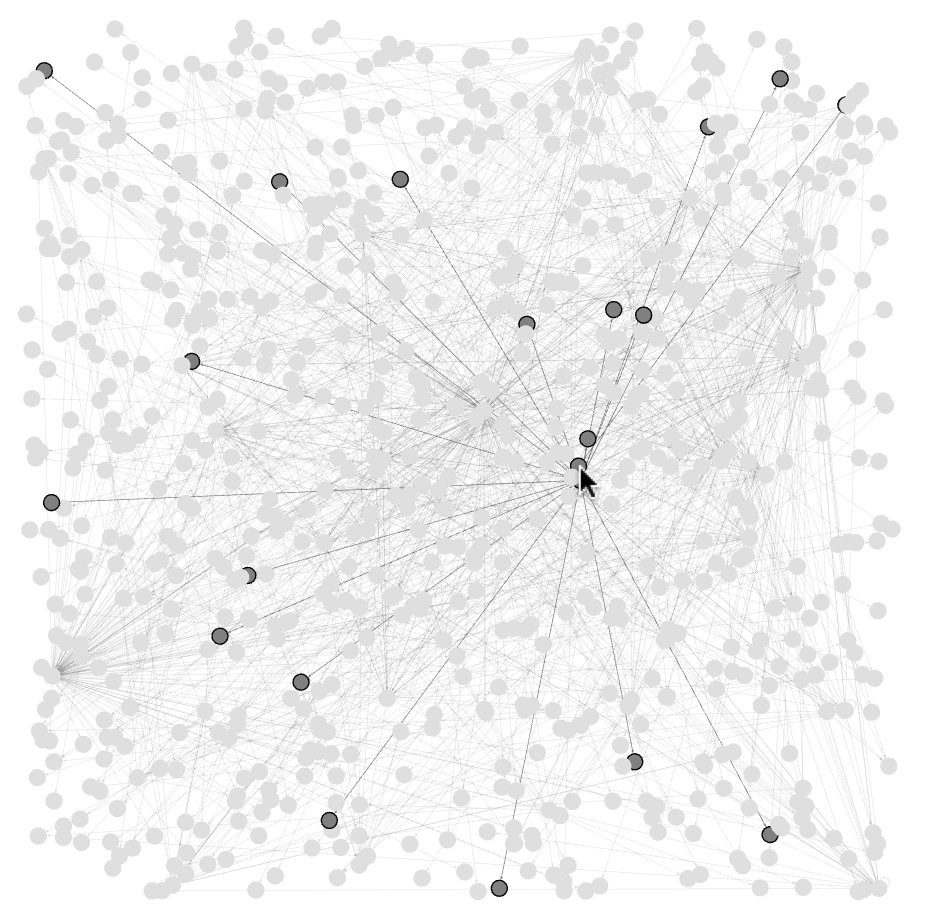

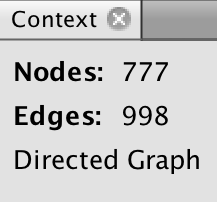

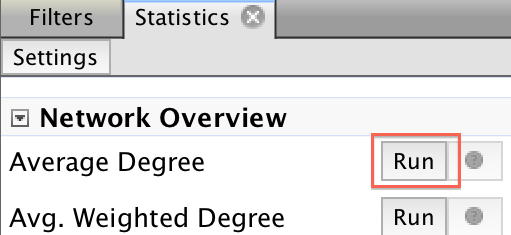

- Valence : Cela fait référence à la connectivité. Plus les données sont connectées, plus leurs valences sont élevées. Un jeu de données à haute valence est plus dense. Cela rend de nombreuses critiques analytiques régulièrement très inefficaces.

- Valeur : le terme, en général, fait référence aux connaissances précieuses tirées de la capacité à étudier et à identifier de nouveaux modèles et tendances issus de systèmes à volume élevé et multiplateforme. L’idée du traitement de toutes ces données volumineuses est d’apporter de la valeur à la requête en question. Le résultat final de toutes les tâches est la valeur.

Voici une représentation résumée du contenu précédent :

1.2 Sources et types de données volumineuses

Nous avons appris que le Big Data est omniprésent et qu’il peut être avantageux pour les entreprises de plusieurs manières. Avec la forte prévalence de données volumineuses provenant du matériel et des logiciels existants, les entreprises ont encore du mal à traiter, stocker, analyser et gérer les données volumineuses à l’aide d’outils et de techniques d’extraction de données traditionnels. Dans cette section, nous allons explorer les sources de ces données complexes et dynamiques et comment les utiliser.

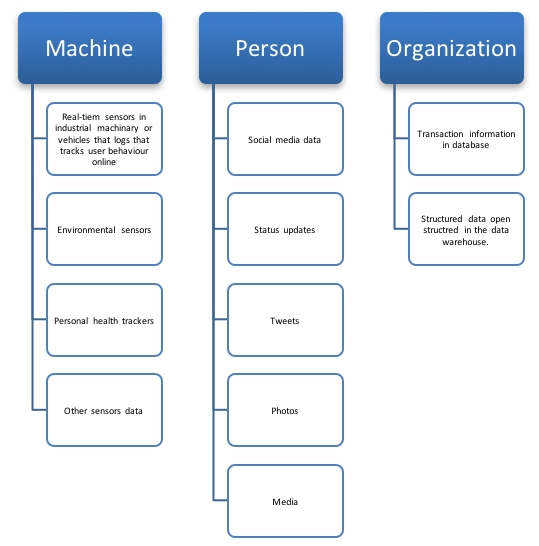

Nous pouvons séparer les sources de données en trois grandes catégories. Le diagramme suivant présente les trois principales sources de données volumineuses :

Examinons les trois sources principales une par une :

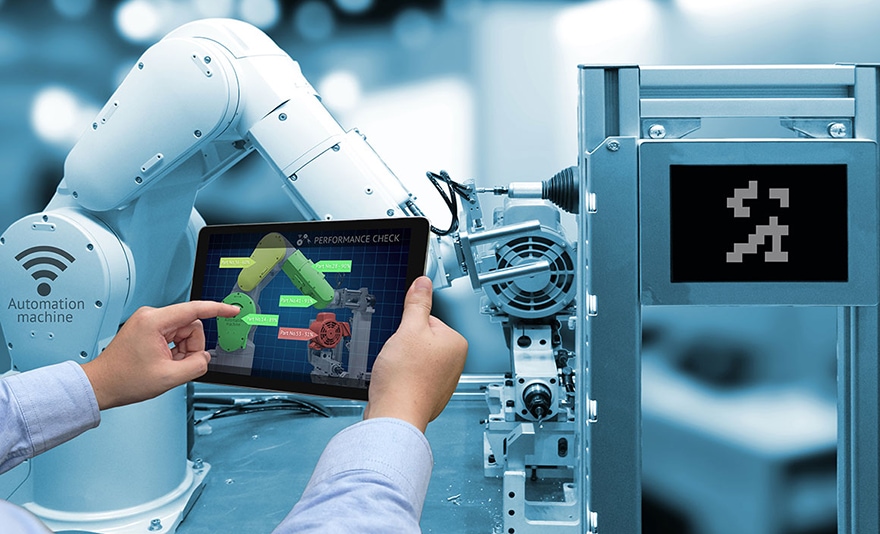

- Journaux générés par une machine : une grande partie du Big Data est générée par des capteurs en temps réel de machines industrielles ou de véhicules qui créent des journaux permettant de suivre les comportements des utilisateurs, des capteurs environnementaux ou des suivis de santé personnels et autres données de capteurs. La plupart des données créées par la machine peuvent être regroupées dans les sous-catégories suivantes :

- Journal des clicks des données de flux : Il s’agit des données qui sont capturées chaque fois qu’un utilisateur clique sur un lien d’un site Web. Une analyse détaillée de ces données peut révéler des informations relatives au comportement des clients et aux interactions profondes des utilisateurs avec le site Web actuel, ainsi que les habitudes d’achat des clients.

- Données du journal des événements du jeu : Un utilisateur effectue un ensemble de tâches lorsqu’il joue à un jeu en ligne. Chaque mouvement que l’utilisateur en ligne effectue dans un jeu peut être stocké. Ces données peuvent être analysées et les résultats peuvent être utiles pour savoir comment les utilisateurs finaux sont propulsés dans un portefeuille de jeux.

- Données du journal des capteurs : Les différents types de données du journal des capteurs impliquent des étiquettes d’identification par radiofréquence, des compteurs intelligents, des données de capteur Smartwatch, des dispositifs de capteurs médicaux tels que des capteurs de contrôle de la fréquence cardiaque et des données GPS. Ces types de données de journal de capteurs peuvent être enregistrés puis utilisés pour analyser le statut réel du sujet.

- Données d’événement de weblog : Les serveurs, les infrastructures cloud, les applications, les réseaux, etc., sont très utilisés. Ces applications fonctionnent et enregistrent toutes sortes de données sur leurs événements et leur fonctionnement. Lorsqu’elles sont stockées, ces données peuvent représenter des volumes de données énormes et peuvent être utiles pour comprendre comment traiter les contrats de niveau de service ou pour prévoir les violations de la sécurité.

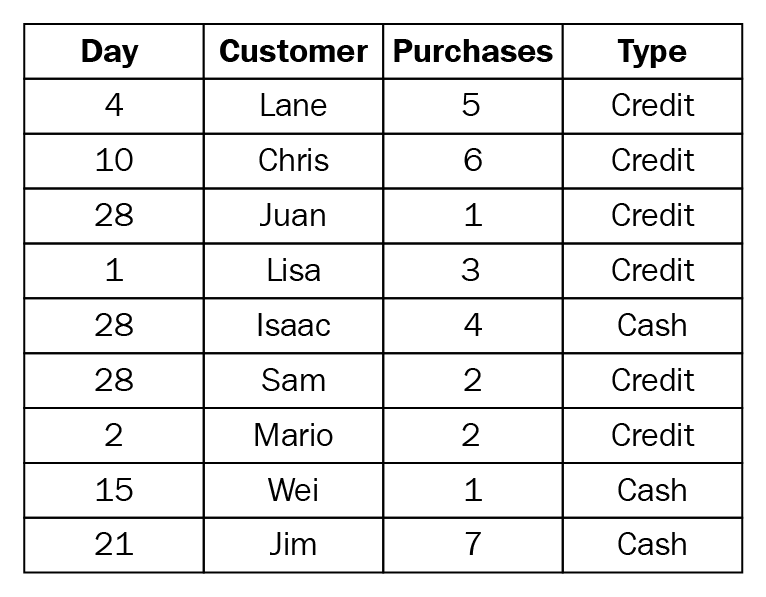

- Données du journal des événements d’un point de vente : Presque tous les produits de nos jours ont un code à barres unique. Un caissier dans un magasin ou un département balaye le code-barres de tout produit lors de la vente et toutes les données associées au produit sont générées et peuvent être capturées. Ces données peuvent être analysées pour comprendre le modèle de vente d’un détaillant.

- Personne : les utilisateurs génèrent beaucoup de données volumineuses à partir de médias sociaux, de mises à jour de statut, de tweets, de photos et de téléchargements multimédias. La plupart de ces journaux sont générés par les interactions d’un utilisateur avec un réseau, tel qu’Internet. Cette révélation de données contient comment un utilisateur communique avec le réseau. Ces journaux d’interaction peuvent révéler des modèles d’interaction de contenu approfondis qui peuvent être utiles pour comprendre le comportement des utilisateurs. Cette analyse peut être utilisée pour former un modèle présentant des recommandations personnalisées d’articles Web, y compris les prochaines informations à lire, ou très probablement, les produits à envisager. Un grand nombre d’études similaires sont très en vogue dans l’industrie actuelle, notamment l’analyse des sentiments et des sujets. La plupart de ces données ne sont pas structurées, car il n’existe pas de format approprié ni de structure bien définie. La plupart de ces données se présentent sous forme de texte, de document portable, de fichier CSV ou de fichier JSON.

- Organisation : une organisation reçoit énormément de données en termes d’informations sur les transactions dans des bases de données et de données structurées ouvertes stockées dans l’entrepôt de données. Ces données sont une forme de données hautement structurée. Les organisations stockent leurs données sur un type de SGBDR, tel que SQL, Oracle et MS Access. Ces données résident dans un format fixe à l’intérieur du champ ou d’une table. Les données générées par cette organisation sont utilisées et traitées dans les technologies de l’information et des communications pour comprendre l’intelligence commerciale et l’analyse de marché.

1.2.1 Les défis du Big Data

Certains aspects essentiels rendent le Big Data très difficile. Dans cette section, nous en discuterons certains :

- Hétérogénéité : les informations consommées par l’homme sont très diverses et elles sont également tolérées. En fait, la nuance et la richesse du langage naturel fourniront une profondeur précieuse. Cependant, les algorithmes d’analyse automatique attendent des connaissances cohérentes et ne permettent pas de comprendre les nuances. Par conséquent, les connaissances doivent être soigneusement structurées avant ou avant l’analyse des connaissances. Les systèmes informatiques fonctionnent plus efficacement s’ils peuvent stocker plusieurs éléments de taille et de structure identiques. La représentation économique, l’accès et l’analyse des connaissances semi-structurées nécessitent des travaux supplémentaires.

- Protection de la vie privée : de nombreuses informations personnelles sont saisies, stockées, analysées et traitées par les fournisseurs de services Internet, les réseaux mobiles, les opérateurs, les supermarchés, les transports locaux, les établissements d’enseignement et les organismes de services médicaux et financiers, y compris les hôpitaux, banques, compagnies d’assurance et agences de cartes de crédit. Une grande quantité d’informations est stockée sur des réseaux sociaux tels que Facebook, YouTube et Google. Cela met en lumière le fait que la confidentialité est un problème dont l’importance, en particulier pour le client, augmente à mesure que la valeur du Big Data devient plus apparente. Ces données personnelles sont utilisées par les algorithmes d’exploration de données pour personnaliser le contenu des actualités et gérer les annonces, ainsi que pour d’autres avantages du commerce électronique. Ceci est clairement une violation de la vie privée.

- Échelle : comme son nom l’indique, le Big Data est énorme. Lorsque la taille augmente, des problèmes sous-jacents l’accompagnent en termes de stockage, de récupération, de traitement, de transformation et d’analyse. Comme indiqué dans l’introduction, le volume de données évolue beaucoup plus rapidement que les ressources informatiques et les vitesses de processeur, qui sont statiques.

- Actualité : il s’agit de la rapidité, car plus la taille des données à traiter est grande, plus il faudra de temps pour l’analyser. Il existe de nombreux scénarios dans lesquels les résultats de l’analyse sont requis en temps réel ou immédiatement. Cela crée un défi supplémentaire lors de la création d’un système capable de traiter les mégadonnées en temps voulu.

- Sécurisation du Big Data : la sécurité est également une préoccupation majeure des entreprises et des particuliers. Les grands magasins de données peuvent être des cibles attrayantes pour les pirates ou des menaces persistantes complexes. La sécurité est un attribut essentiel de l’architecture Big Data qui révèle des moyens de stocker et de fournir un accès aux informations en toute sécurité.

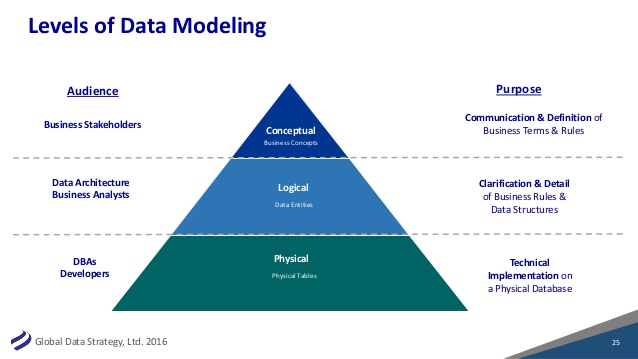

1.3 Introduction à la modélisation Big Data

Ayant une bonne idée de ce que sont les mégadonnées et leurs caractéristiques, passons maintenant à la modélisation. Supposons que nous ayons l’ensemble de données, que nous classons comme étant des données volumineuses, et avant de procéder à toute analyse sur l’ensemble de données, nous devons avoir une idée de l’apparence des données. La modélisation des données a pour objectif d’explorer de manière formelle la nature des données afin de déterminer le type de stockage dont vous avez besoin et le type de traitement que vous pouvez effectuer.

La modélisation des données est une technique qui aide à donner un aperçu significatif des données en les définissant et en les catégorisant, et en établissant des définitions et des descripteurs officiels afin que les données puissent être utilisées par tous les systèmes d’information d’une entreprise.

Nous pouvons avoir au moins deux raisons principales pour effectuer la modélisation de données :

- La modélisation de données stratégique facilite la stratégie globale de développement des systèmes d’information

- La modélisation des données peut aider au développement de nouvelles bases de données

La modélisation des données pour la définition stratégique suggère de définir le type de données dont vous aurez besoin pour les processus de votre entreprise, tandis que la modélisation dans le contexte de l’analyse est davantage axée sur la représentation des données existantes et sur la recherche de moyens de les classer. Dans le cas du Big Data, ce processus nécessite probablement de trouver des similitudes entre des données provenant de sources disparates et de confirmer qu’elles décrivent effectivement la même chose. Dans les deux cas, l’objectif final est de générer une représentation de vos données pouvant être répliquée dans votre architecture de base de données.

1.3.1 Utilisation des modèles

Dans cette section, nous allons discuter des raisons pour lesquelles nous avons besoin de modèles de données et des principaux avantages que nous pouvons obtenir en étudiant les modèles de données actuels. Un modèle de données de haut niveau illustre les concepts et principes de base de toute entreprise de manière très simpliste, en utilisant de courtes descriptions. L’un des principaux avantages de l’élaboration du modèle de haut niveau est qu’il nous aide à parvenir à une terminologie et à des définitions communes des idées et des principes.

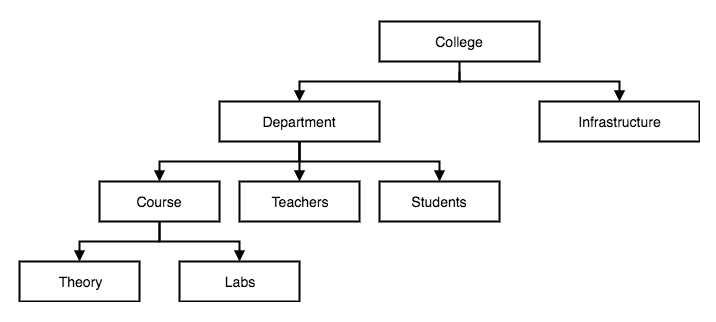

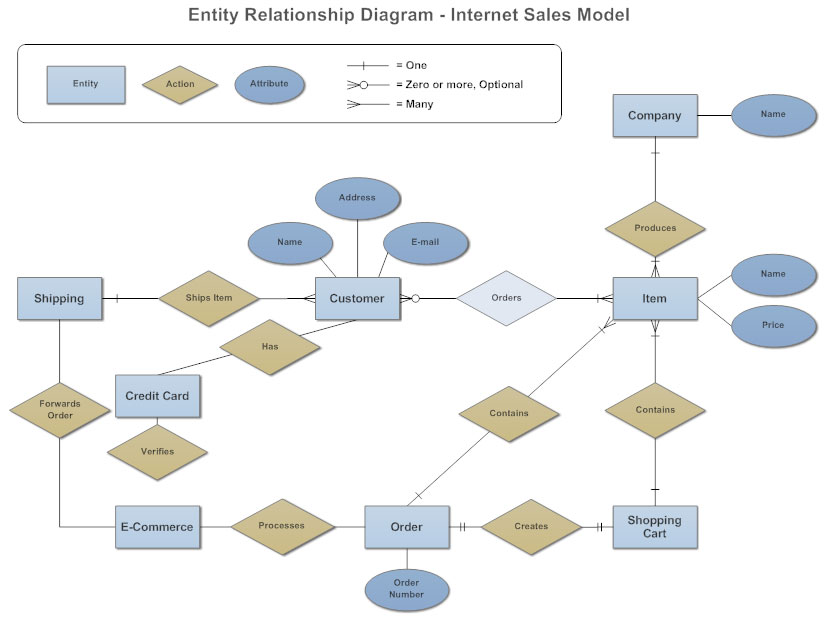

Un modèle de données de haut niveau utilise des images graphiques simplistes pour illustrer les concepts et principes de base d’une organisation et leur signification. Un modèle de base de données montre la structure logique d’une base de données, y compris les relations et les contraintes qui déterminent la manière dont les données peuvent être stockées et accessibles.

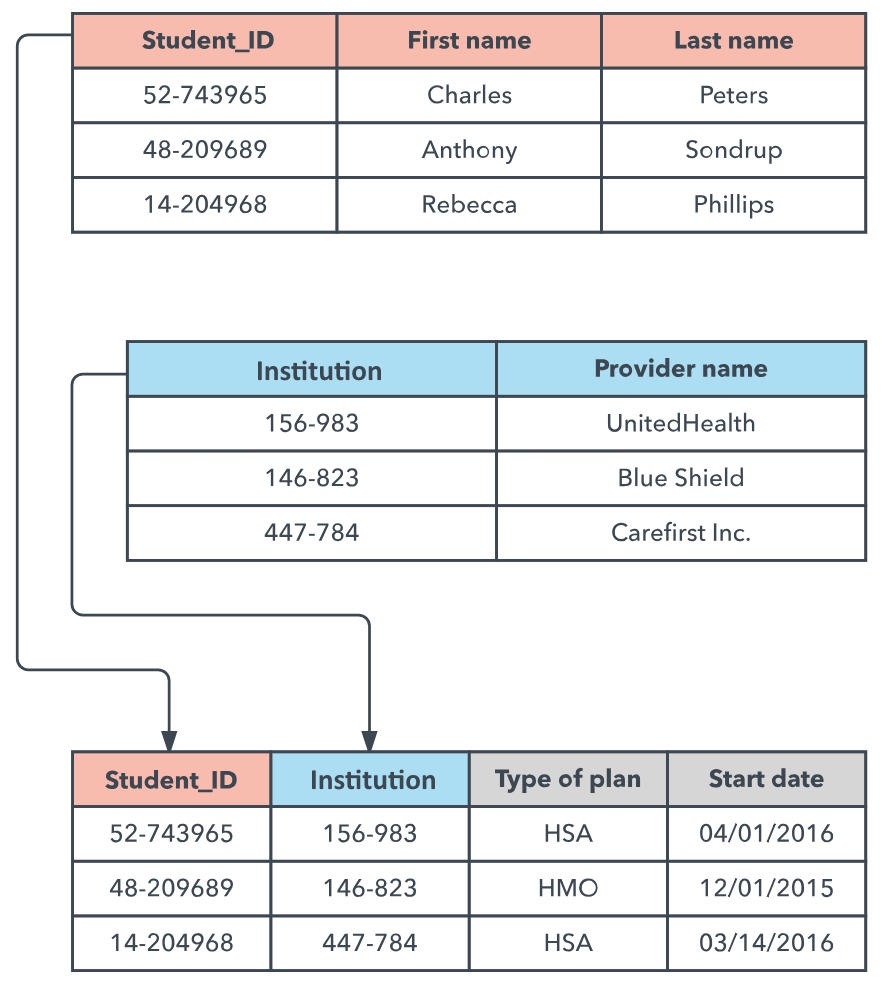

Prenons un système simple d’enregistrement de notes par les étudiants. Un élève a un prénom, un nom de famille et un identifiant unique. Chaque étudiant est associé à une institution. Chaque élève a une date de début et d’autres données qui lui sont associées. Nous pouvons mieux représenter cela en utilisant une sorte de modèle que dans un paragraphe, ce qui est difficile à comprendre.

Convertissons-le en modèle :

Modèle 1.1

Considérons maintenant le modèle précédent. Il montre clairement la corrélation entre les étudiants et le fournisseur de l’établissement et la façon dont ils sont enregistrés dans plusieurs tableaux. C’est plus facile à comprendre qu’un paragraphe. Analysons maintenant ce modèle et voyons quels avantages nous en retirons par rapport à d’autres représentations textuelles :

- Gagner en perspicacité : un modèle détaillé montre le processus sous différents angles. Comme dans le modèle précédent, nous pouvons voir comment les étudiants sont associés aux établissements fournisseurs, aux différents types de régimes et à quel moment débute un cours. Pour commencer avec la modélisation des données, il est important de connaître les éléments suivants :

- Comprendre le fonctionnement de l’entreprise pour comprendre le flux de données au sein de l’organisation.

- Comprendre quel type de données est collecté et stocké dans l’organisation.

- Compréhension des processus et des relations commerciales. Cette connaissance nous guide dans la création de données et de relations dans un modèle de données.

- Discussion : Le modèle de données détaillé peut être utilisé pour des discussions avec les parties prenantes.

- Transfert de connaissances : il peut être utilisé comme source de documentation pour instruire des personnes ou des développeurs. La modélisation des données est une sorte de documentation, à la fois pour les acteurs de l’entreprise et les experts techniques. En commençant par fournir un vocabulaire commun que différents rôles peuvent partager, et en continuant à fournir aux nouveaux arrivants un glossaire professionnel bien pensé, vos connaissances pour documenter et transmettre des informations sur votre entreprise sont considérablement améliorées. En plus de cela, le modèle peut être utilisé comme aide à la formation.

- Vérification : les modèles de processus sont analysés pour détecter les erreurs dans les systèmes ou les procédures. Si votre cahier des charges était complet et comprenait la fusion de données provenant de sources multiples, ainsi que des obligations en matière de requête et de reporting, vous disposiez d’opportunités de Business Intelligence inexistantes lorsque vos données existaient en silos ou dans des bases de données conçues au hasard.

- Analyse des performances : un modèle détaillé à partir des données peut être utilisé pour analyser les performances du système en utilisant plusieurs techniques disponibles, telles que les simulations, et la lecture à sec dans le modèle.

- Spécification : un modèle pertinent généré à partir des données d’une organisation peut être utilisé pour créer un document de spécification des exigences logicielles (SRS) pouvant être utilisé comme feuille de route entre un développeur et des parties prenantes de l’utilisateur final.

- Configuration : Les modèles construits à partir de données peuvent être appliqués pour configurer un système. Un modèle détaillé construit avec précision montre la relation entre les modules et comment un module peut communiquer avec un autre module. Ces informations peuvent être utilisées par n’importe quelle organisation pour renforcer l’interopérabilité entre les modules et leurs paramètres de configuration et réduire les redondances.

1.4 Introduction à la gestion du Big Data

Le but de la gestion des mégadonnées est de déterminer le type de support d’infrastructure dont vous auriez besoin pour les données. Par exemple, votre environnement doit-il conserver plusieurs répliques des données ? Avez-vous besoin de faire un calcul statistique avec les données ? Une fois que ces exigences opérationnelles ont été déterminées, vous serez en mesure de choisir le bon système qui vous permettra d’effectuer ces opérations. Le Big Data Management répond aux questions suivantes :

- Comment ingérons-nous ou consommons-nous les données ?

- Où et comment le stockons-nous ?

- Comment pouvons-nous assurer et appliquer la qualité des données ?

- Quelles opérations effectuons-nous sur les données ?

- Comment ces opérations peuvent-elles être efficaces ?

- Comment gérons-nous l’évolutivité, la variété, la vitesse et l’accès des données ?

- Comment pouvons-nous renforcer la sécurité et la confidentialité à chaque étape de la modélisation des données ?

La gestion des données volumineuses est un concept global qui englobe les politiques, procédures et techniques utilisées pour la collecte, le stockage, la gouvernance, l’organisation, l’administration et la livraison de grands référentiels de données.

Nous entrerons dans les détails de la gestion de Big Data, et nous discuterons des détails de la gestion de données ainsi que de leurs fournisseurs dans le chapitre suivant, Chapitre 2, Plateformes de modélisation et de gestion de données.

1.5 Importance et implications de la modélisation et de la gestion de données volumineuses

Nous avons constaté que les mégadonnées avaient une importance économique et scientifique. La conviction scientifique est que plus les données utilisées dans la recherche sont volumineuses, plus leur précision est grande. Les données sont générées toutes les secondes dans la vie réelle, ce qui signifie que le volume de données disponibles ne peut jamais diminuer, mais il continuera de croître. Il est également important de reconnaître qu’une grande partie de cette explosion de données est le résultat d’une explosion de périphériques situés à la périphérie du réseau, notamment de capteurs intégrés, de smartphones et de tablettes. Toutes ces données créent de nouvelles opportunités pour les analystes de données dans les domaines de la génomique humaine, des soins de santé, du pétrole et du gaz, de la recherche, de la surveillance, des finances et de nombreux autres domaines. Dans cette section, nous allons explorer les différents avantages de la gestion de données volumineuses. Dans la section suivante, nous découvrirons divers défis de la gestion de données volumineuses sur le marché actuel.

1.5.1 Avantages de la gestion de données volumineuses

Comme mentionné, le Big Data est un outil puissant. Une gestion réfléchie du Big Data constitue une avancée décisive et permet de prendre des décisions commerciales plus solides. Dans cette section, nous allons discuter de plusieurs avantages de la gestion de données volumineuses :

- Accélère les revenus : lorsque les données sont gérées correctement et efficacement, cela donne de la valeur. La valeur contribue à l’accélération des revenus des petites et moyennes entreprises.

- Amélioration du service à la clientèle : plusieurs études montrent que les entreprises qui utilisent les données précédentes pour obtenir des informations décisionnelles ont amélioré leurs services à la clientèle, les modèles exploités guidant l’activité en surmontant les goulots d’étranglement du système actuel.

- Améliore le marketing : l’analyse des données massives révèle une analyse plus approfondie des données commerciales passées et actuelles, ainsi que des informations sur la manière de gérer l’entreprise à l’avenir. Cela donne un chemin guidé pour savoir comment proposer des solutions marketing critiques et innovantes.

- Efficacité accrue : l’identification d’une nouvelle source de données a été modérément facilitée avec l’introduction d’outils à grande vitesse tels que Hadoop. Ces outils aident les entreprises à analyser les données en temps réel et à accélérer la prise de décision.

- Économies de coûts : les services en nuage attirent de plus en plus l’attention et ont été utilisés avec succès dans de nombreuses applications de gestion de données d’entreprise. Des outils tels que Hadoop sont basés sur le cloud et sont plus faciles à manipuler. Ces systèmes permettent de réduire les coûts en fournissant des interfaces plus faciles sur lesquelles stocker, analyser et visualiser des données volumineuses.

- Amélioration de la précision des analyses : La précision et la fiabilité des analyses de données volumineuses ont été améliorées par les pratiques de gestion des données. Les services de gestion de données constituent un moyen meilleur et moins coûteux de transformer des données en intelligence d’affaires, augmentant ainsi la précision et l’analyse.

1.5.2 Défis de la gestion de données volumineuses

Avec une énorme explosion de données dans plusieurs entreprises, les entreprises ont tout intérêt à explorer des solutions offrant des opportunités et des perspectives pour augmenter leurs bénéfices. Cependant, il est toujours difficile de gérer et de maintenir le Big Data. Certains des principaux défis du processus de gestion du Big Data sont décrits ci-après :

- Augmentation du nombre de magasins de données (Data Stores) : la gestion des données est une tâche très complexe et complexe, car elle nécessite un volume de données considérable et son augmentation constante. Il est également très important d’effectuer toute opération sur cet ensemble de données, car cela peut nuire à la qualité et aux performances de l’analyse. Il peut s’avérer très complexe de migrer une base de données vers une solution analytique en raison de l’expansion continue des magasins de données et des silos de données.

- Complexité des données et des structures : les entreprises ont généralement à la fois des données structurées et des données non structurées. Ces données se présentent sous un très grand nombre de formats, notamment JSON, CSV, un fichier document, un fichier texte ou des données BLOB. Une entreprise a généralement plusieurs milliers d’applications sur ses systèmes et chacune de ces applications peut numériser et écrire dans plusieurs bases de données distinctes. Par conséquent, il est souvent extrêmement difficile de cataloguer les styles de données d’une entreprise dans ses systèmes de stockage.

- Assurer la qualité des données : il est l’un des atouts essentiels des entreprises pour assurer la fiabilité et la précision des données. Comme mentionné, le manque de synchronisation entre les silos de données et les entrepôts de données peut compliquer la tâche des gestionnaires pour comprendre quelle partie des données est exacte et complète. Si un utilisateur entre les mauvaises données, la sortie générée est également incorrecte. Ceci est appelé garbage in, garbage out (GIGO). Ce type d’erreur est appelé une erreur humaine.

- Peu de personnel : Il est difficile et c’est un défi de trouver du personnel qualifié ayant une connaissance correcte du domaine problématique. Le manque de scientifiques de données, d’administrateurs de bases de données (DBA), d’analystes de données, de concepteur de modèle de données et de différents professionnels du Big Data rend le travail de gestion de données très difficile.

- Manque de soutien de la part des dirigeants : les cadres supérieurs ne comprennent généralement pas l’importance et la valeur d’une bonne gestion des données. Il est très difficile de les convaincre et de montrer les feuilles de route de la façon dont ces techniques de gestion seraient bénéfiques pour l’organisation. En d’autres termes, la plupart des cadres supérieurs sont satisfaits de leurs solutions de pointe pour le domaine problématique.

1.6 Big Data Plateformes de modélisation

Dans cette section, nous allons configurer Cloudera VM sous Windows et macOS. Nous allons utiliser cette machine virtuelle pour la plupart des exercices de ce livre.

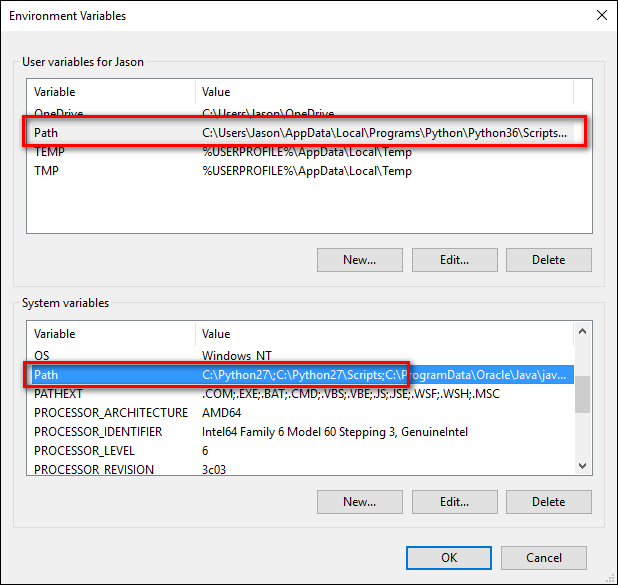

1.6.3 Débuter sur Windows

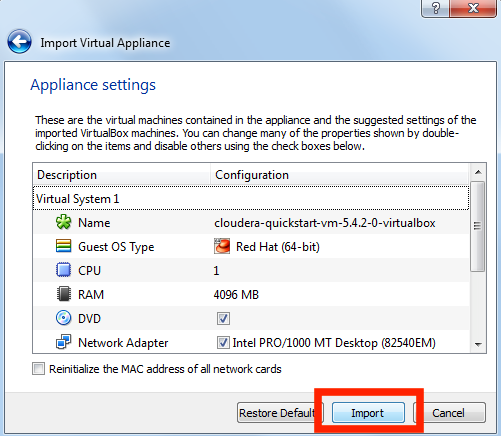

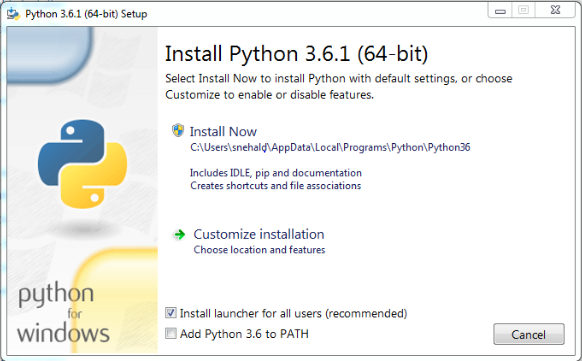

Nous allons installer la machine virtuelle Cloudera dans notre système pour commencer à modéliser les données volumineuses. Suivez ces instructions pour télécharger et installer la machine virtuelle Cloudera Quickstart avec VirtualBox sous Windows :

- Téléchargez le logiciel à l’adresse https://www.virtualbox.org/wiki/Downloads. Une fois le téléchargement terminé, installez le logiciel VirtualBox téléchargé sur votre ordinateur.

- Téléchargez la machine virtuelle Cloudera à l’adresse https://downloads.cloudera.com/demo_vm/virtualbox/cloudera-quickstart-vm-5.4.2-0-virtualbox.zip. La machine virtuelle dépasse 4 Go. Il faudra du temps pour télécharger le logiciel.

- Cliquez avec le bouton droit de la souris sur Cloudera-quickstart-vm-5.4.2-0-virtualbox.zip et choisissez Extract All…

- Démarrez la VirtualBox.

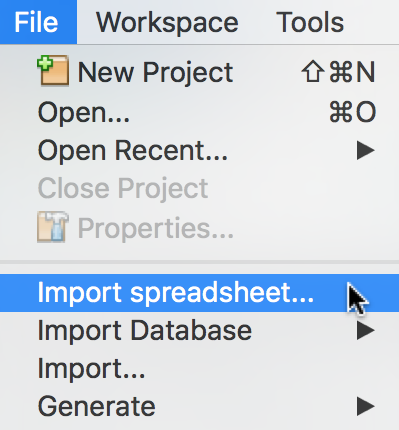

- Importez la VM en allant dans File | Import Appliance …:

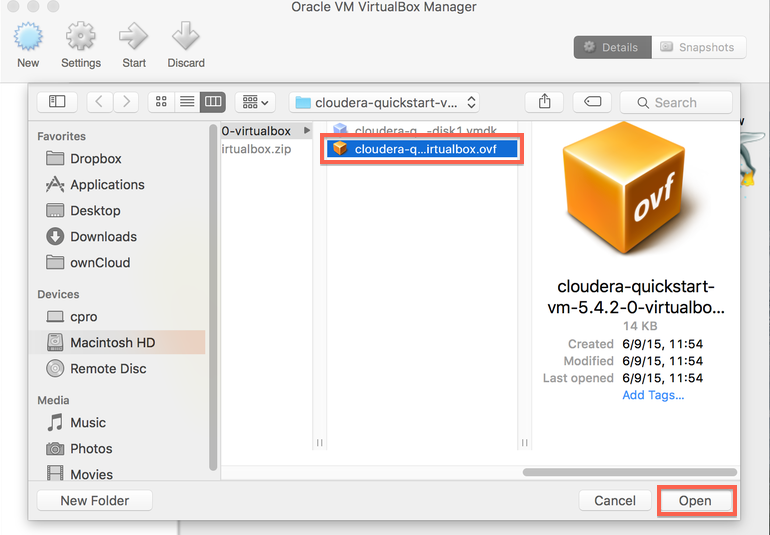

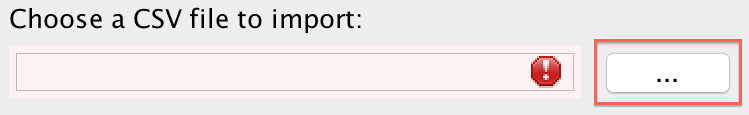

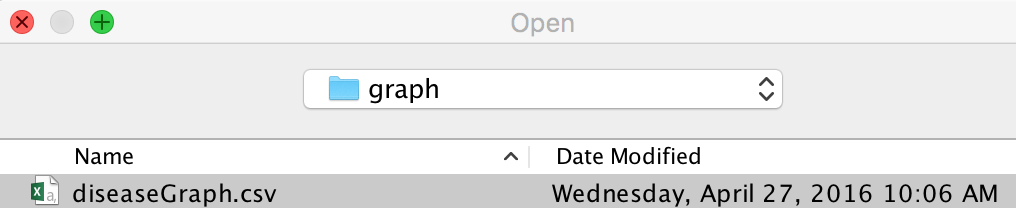

- Cliquez sur l’icône du dossier, sélectionnez cloudera-quickstart-vm-5.4.2-0-virtualbox.ovf dans le dossier où vous avez dézippé la machine virtuelle VirtualBox, puis cliquez sur Open. La capture d’écran suivante est fournie à titre d’aide :

- Cliquez sur Next pour continuer, puis sur Import, comme illustré dans la capture d’écran suivante :

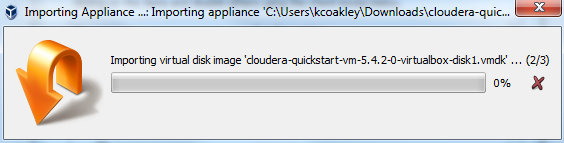

- L’image de la machine virtuelle sera importée. Comme il s’agit d’un gros fichier, cela peut prendre un certain temps :

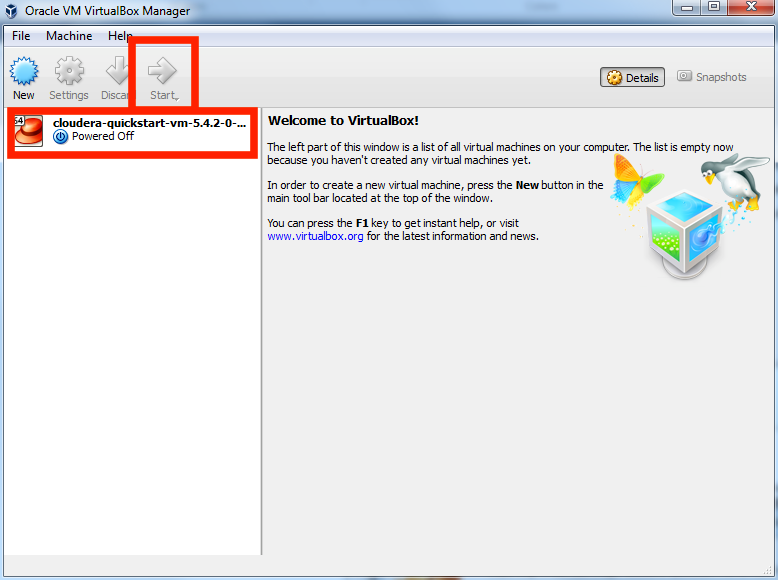

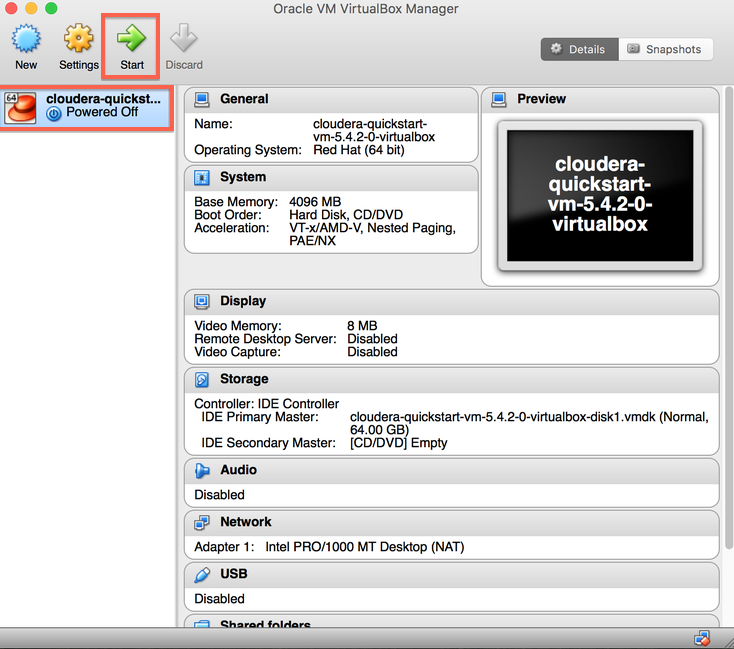

- Une fois l’importation terminée, lancez la machine virtuelle Cloudera. cloudera-quickstart-vm-5.4.2-0 VM apparaîtra à gauche dans la fenêtre de VirtualBox. Sélectionnez la machine et cliquez sur le bouton Start pour lancer la machine virtuelle :

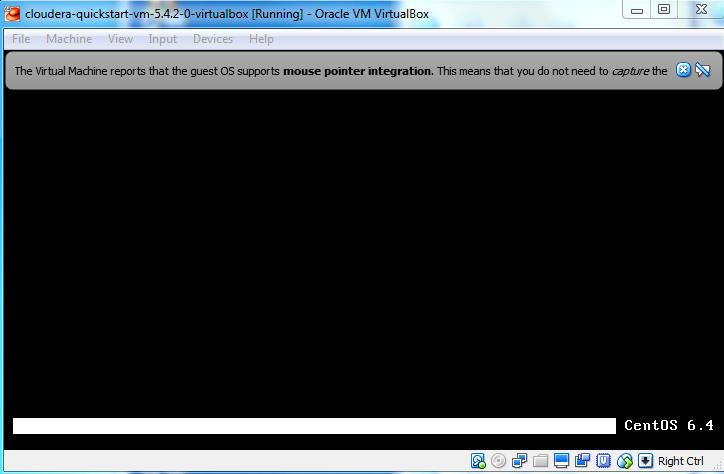

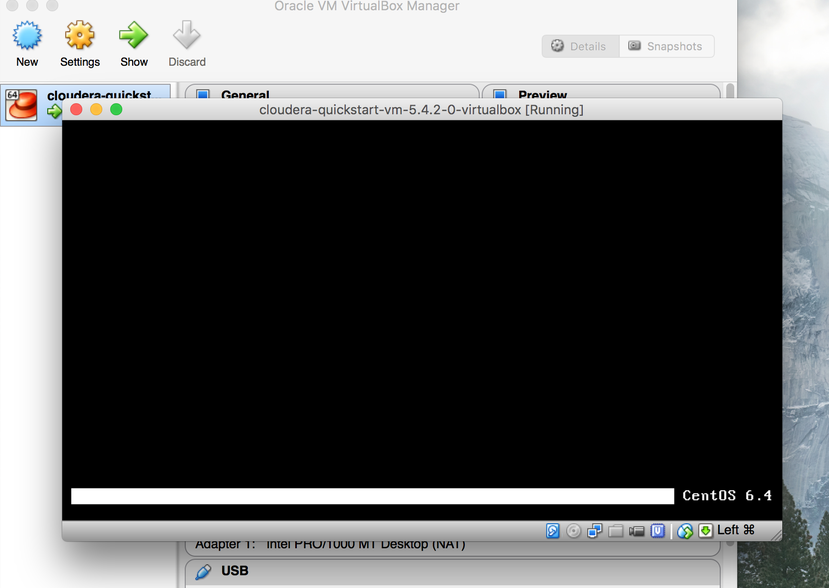

- Le démarrage initial de la machine virtuelle Cloudera prend plusieurs minutes. Cela prend beaucoup de temps, car de nombreux outils Hadoop sont chargés et démarrés à ce processus de démarrage :

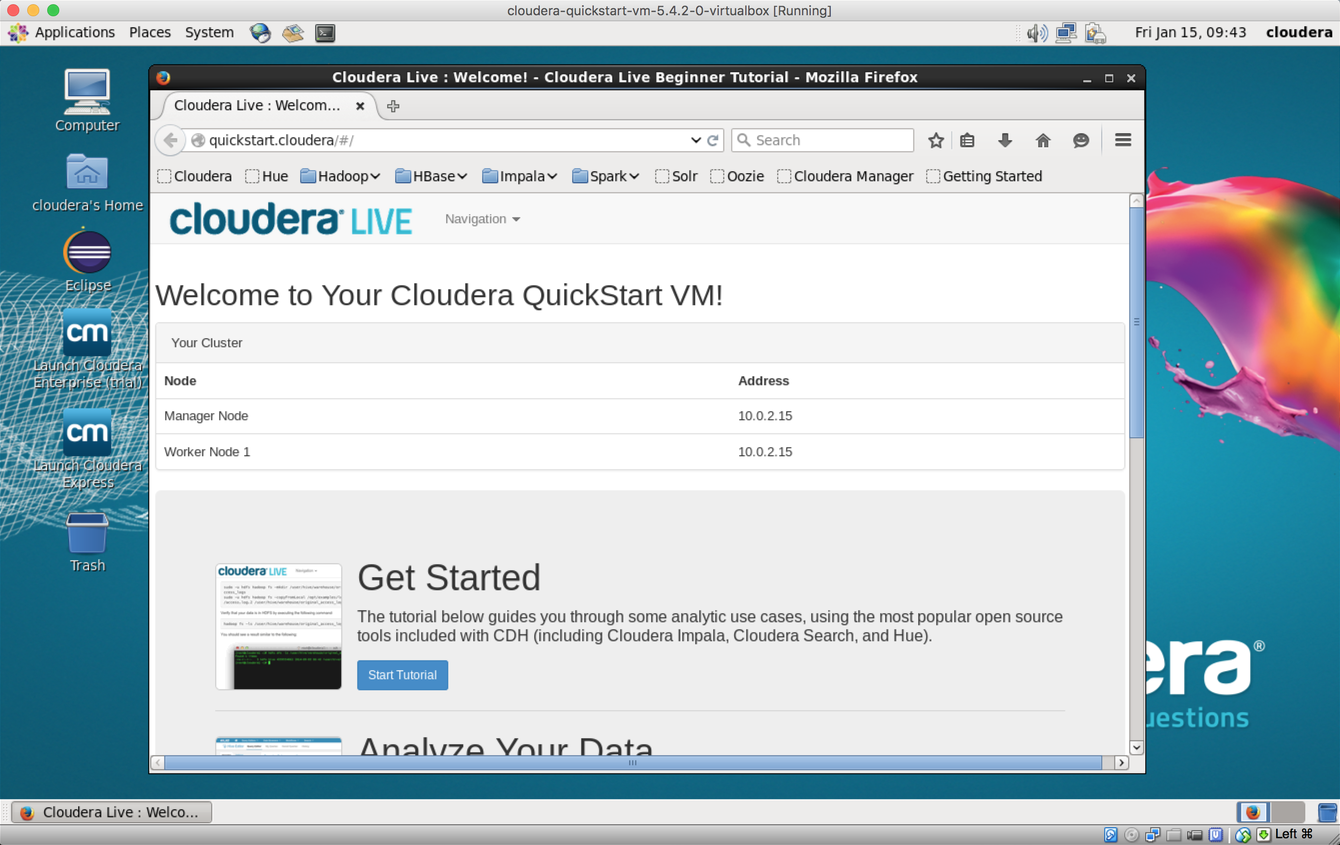

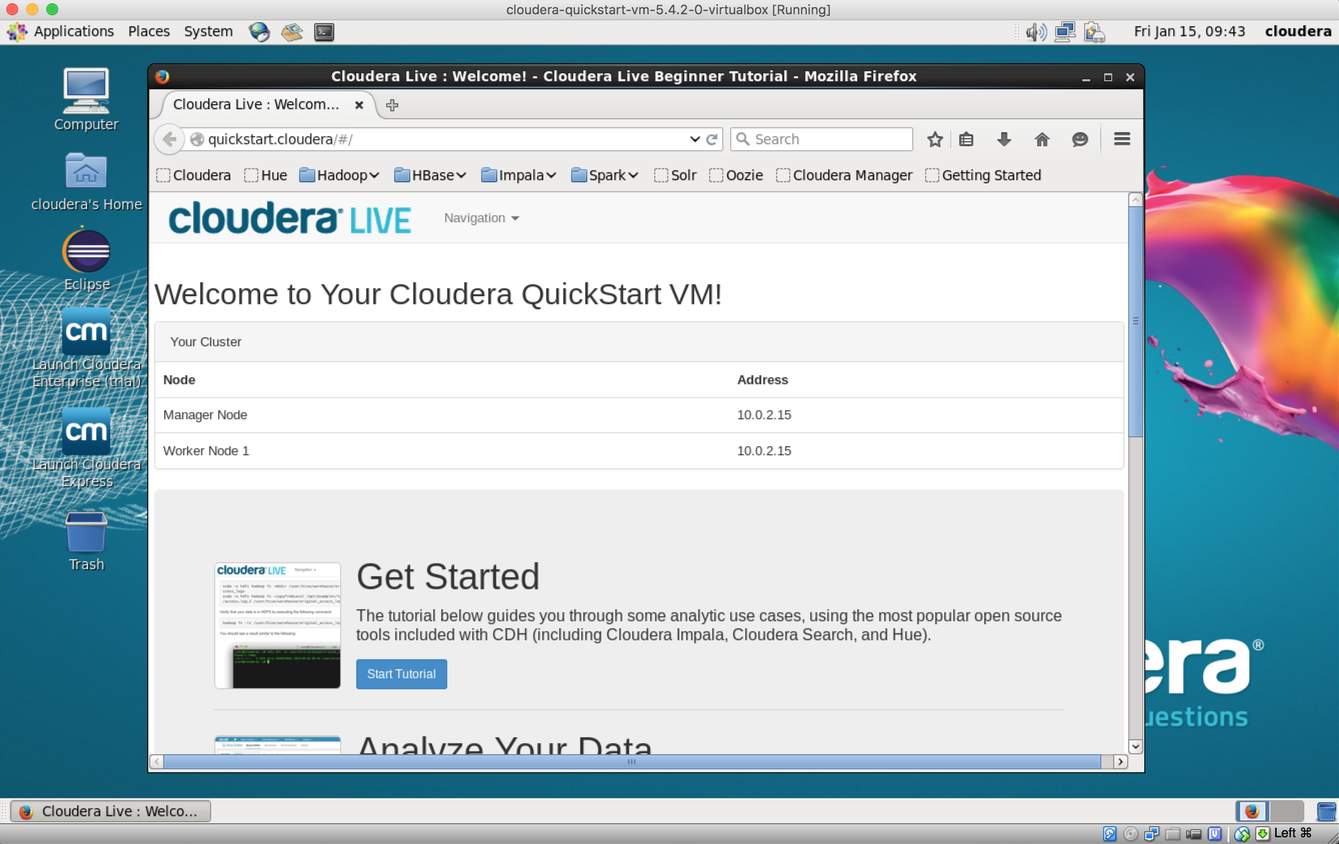

- Une fois le processus de démarrage terminé, vous verrez le bureau Cloudera VM à l’écran :

1.6.2 Démarrer sur macOS

La configuration de la machine virtuelle Cloudera sur un Mac est très similaire à celle de Windows. Si vous avez macOS, nous pouvons configurer la VM Cloudera Quickstart avec VirtualBox sur macOS. Effectuez les étapes suivantes :

- Allez sur https://www.virtualbox.org/wiki/Downloads et téléchargez la boîte virtuelle. Une fois téléchargé, installez VirtualBox dans macOS.

- Téléchargez la machine virtuelle Cloudera à l’adresse https://downloads.cloudera.com/demo_vm/virtualbox/cloudera-quickstart-vm-5.4.2-0-virtualbox.zip. La VM a plus de 4 Go, le téléchargement prendra donc un certain temps.

- Décompressez la VM Cloudera. Vous pouvez le faire en double-cliquant sur le dossier cloudera-quickstart-vm-5.4.2-0-virtualbox.zip.

- Démarrez la VirtualBox et lancez l’importation. Nous pouvons importer la VM en allant dans File | Import Applicance.

- Cliquez sur l’icône Dossier, sélectionnez cloudera-quickstart-vm-5.4.2-0-virtualbox.ovf dans le dossier où vous avez dézippé la machine virtuelle VirtualBox, puis cliquez sur Open :

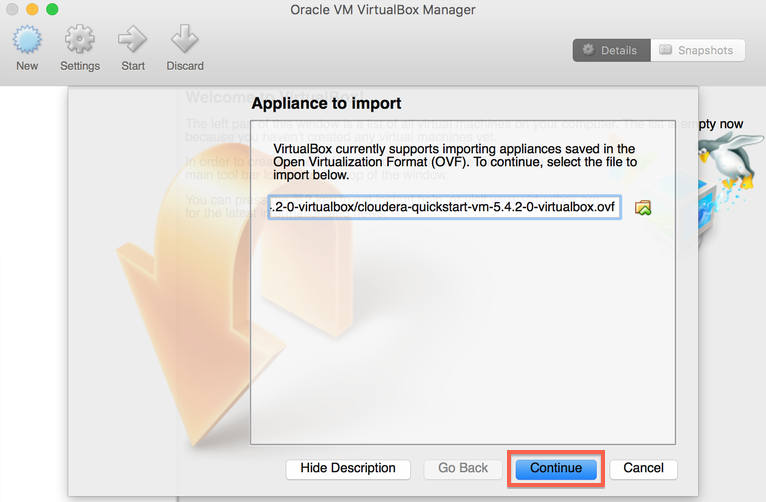

- Cliquez sur Continue pour continuer:

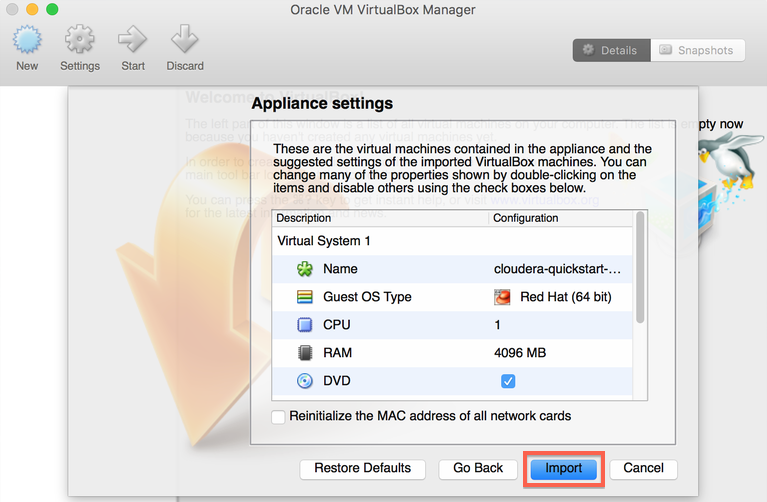

- Cliquez sur Import :

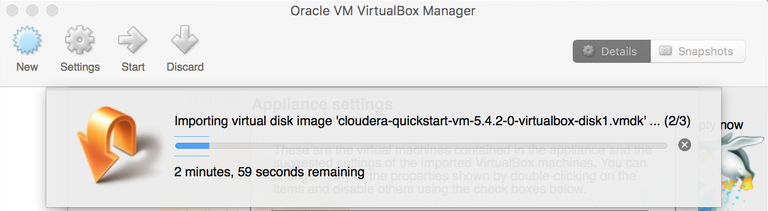

- L’image de la machine virtuelle sera importée. Comme il s’agit d’un gros fichier, cela peut prendre un certain temps :

- Une fois l’importation terminée, lancez la machine virtuelle Cloudera. cloudera-quickstart-vm-5.4.2-0 La machine virtuelle apparaîtra à gauche dans la fenêtre de VirtualBox. Sélectionnez la machine et cliquez sur le bouton Démarrer pour lancer la machine virtuelle :

- Il faut plusieurs minutes au démarrage initial de la machine virtuelle Cloudera pour démarrer. Cela prend beaucoup de temps, car de nombreux outils Hadoop sont chargés et démarrés au cours de ce processus de démarrage :

- Une fois le processus de démarrage terminé, vous verrez le bureau Cloudera VM à l’écran :

1.7 Résumé

Les mégadonnées sont omniprésentes ; il peut être trouvé partout, des petites entreprises aux applications d’entreprise. Il est d’une importance vitale que ces données soient capturées, stockées, récupérées et analysées de la meilleure façon possible afin d’obtenir une analyse et une intelligence économique plus approfondies. Dans ce chapitre, nous avons découvert le concept des mégadonnées et leur origine. Nous avons également discuté des différentes caractéristiques des mégadonnées et des fondements théoriques de la modélisation et de la gestion des données.

En plus de cela, les lecteurs ont eu la possibilité d’installer une plate-forme Big Data sur leur machine locale pour les machines macOS et Windows. Nous utiliserons ces machines dans les prochains chapitres pour créer des modèles de base de données. Dans le prochain chapitre, nous discuterons des plates-formes de modélisation et de gestion des données.

2 Plateformes de modélisation et de gestion de données

Dans le chapitre précédent, nous avons abordé certains aspects théoriques et managériaux du big data, ainsi que l’importance du big data en général. Dans ce chapitre, nous énumérerons certaines questions incontournables concernant la gestion du Big Data. En outre, vous en apprendrez davantage sur les entreprises et les agences gouvernementales qui traitent le Big Data en termes de stockage, de gestion et de traitement. Les mégadonnées présentent de nouveaux défis, obligeant les développeurs basés sur un framework à proposer des solutions. Ils ont introduit plusieurs types d’infrastructures portables et évolutives pour le stockage, la gestion et le traitement du Big Data.

Dans ce chapitre, nous aborderons diverses approches de gestion du Big Data, notamment les étapes nécessaires à l’utilisation des différentes options, ainsi que les fournisseurs qui les fournissent. De plus, nous explorerons diverses plates-formes de programmation disponibles pour la gestion de données volumineuses.

Les sujets suivants seront abordés dans ce chapitre :

- Un aperçu de la gestion du Big Data

- Services de gestion de données volumineuses

- Fournisseurs de gestion de données volumineuses

- Stockage de données volumineuses et modèles de données

- Modèles de programmation Big Data

- Débuter avec Python

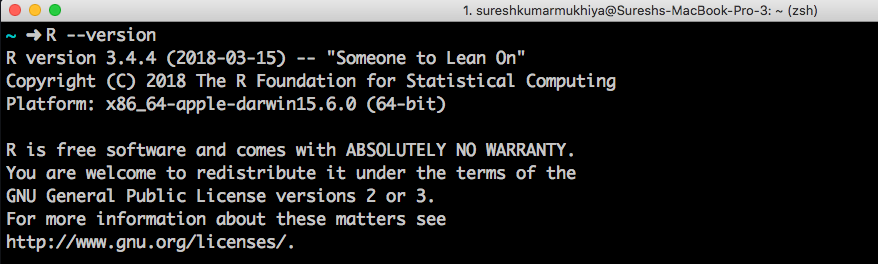

- Débuter avec R

2.1 Gestion des données volumineuses

La gestion des données volumineuses garantit un certain niveau de qualité et d’accessibilité des données pour la veille stratégique, ainsi que pour les applications d’analyse de données volumineuses. La gestion des données volumineuses intègre les politiques, les techniques et les processus utilisés pour la collecte, le stockage, l’administration et la livraison des données, ainsi que pour la livraison de grands référentiels. L’étape peut impliquer le nettoyage, l’intégration, la migration et la création de rapports.

2.1.1 Ingestion de données

L’ingestion de données fait référence au processus d’acquisition de données dans le système. Cela peut être fait via des méthodes manuelles, semi-automatiques ou automatiques.

Remarque :

L’ingestion de données désigne le processus d’introduction des données dans le système de données que nous construisons ou utilisons.

Dans un système plus petit, les utilisateurs préfèrent utiliser un formulaire Web ou une interface visuelle permettant la saisie des données afin de placer les données dans le système. Toutefois, lorsqu’il s’agit d’un système plus vaste, tel qu’un système de gestion d’hôpital, un système de gestion de compagnie aérienne, un système de gestion des archives publiques et publiques ou un site de média social, les utilisateurs préfèrent souvent automatiser autant que possible le processus d’ingestion de données. Ainsi, en ce qui concerne l’ingestion de données, nous devons explorer un ensemble de questions, telles que :

- Combien de sources de données existe-t-il ?

- Combien de données volumineuses sont disponibles ?

- Le nombre de sources de données va-t-il augmenter avec le temps ?

- Quelle est la vitesse à laquelle les données seront consommées ?

Il est très important de noter que la taille d’un enregistrement individuel est petite, mais le volume de données est assez énorme. En ce qui concerne l’ingestion de données, les développeurs aiment créer un ensemble de stratégies, appelées stratégies d’ingestion, qui guident le traitement des erreurs lors de l’ingestion de données, ainsi que le caractère incomplet des données, etc. L’ingestion de données (ainsi que ses politiques) fait partie intégrante d’un système Big Data.

2.1.2 Stockage de données

L’objectif principal d’une infrastructure de stockage est de stocker des données. Les problèmes suivants doivent être pris en compte lors du stockage des données :

- Capacité : La capacité fait référence à la quantité de mémoire à allouer (ou à la taille de la mémoire) pour stocker les données.

- Évolutivité : les périphériques de stockage connectés doivent être évolutifs, car le volume de données augmentera avec le temps. En outre, l’évolutivité concerne la possibilité de se connecter au réseau afin d’obtenir un stockage supplémentaire au fil du temps.

Dans un système de données volumineuses, nous avons le choix d’archiver une infrastructure de stockage en choisissant la quantité de chaque type de stockage dont nous avons besoin. L’utilisation de disques SSD pour stocker une grande quantité de données accélère les opérations de recherche dans les données d’au moins dix fois plus que sur des disques durs ; Cependant, cela augmente aussi le coût.

2.1.3 Qualité des données

Il est important que les données stockées soient utiles, sans erreur et destinées à l’usage auquel elles sont destinées. Des données de haute qualité donnent des informations exploitables, alors que des données de mauvaise qualité conduisent à une analyse médiocre et, conduisent, à de mauvaises décisions. Des erreurs dans les données de ces industries peuvent enfreindre les réglementations et entraîner des complications juridiques. Les facteurs suivants peuvent aider à évaluer la qualité des données :

- Complétude : manque-t-il des valeurs dans l’ensemble de données ?

- Validité : Les données correspondent à l’ensemble de règles.

- Unicité : les données ont des redondances minimes.

- Cohérence : les données sont cohérentes dans différents magasins de données.

- Actualité : les données représentent la réalité à un moment donné.

- Précision : Le degré de conformité du résultat d’une mesure, d’un calcul ou d’une spécification particulière à la valeur correcte.

2.1.4 Opérations de données

Un aspect très important de la gestion des données est la documentation, la définition, la mise en œuvre et le test de l’ensemble des opérations requises pour une application spécifique. En bref, il existe deux ensembles d’opérations distincts utilisés pour la gestion des données, à savoir :

- Une opération qui fonctionne sur un objet singulier : Par exemple, une opération qui recadre une image, en extrayant une sous-zone d’une zone de pixels, est une opération mono-objet, car nous considérons l’image comme un seul objet.

- Une opération qui fonctionne sur des collections d’objets de données : Cette opération consiste à fusionner deux collections afin de former une collection plus grande.

2.1.5 Evolutivité et sécurité des données

Aujourd’hui, la plupart des systèmes de gestion de données volumineuses sont conçus pour fonctionner sur un cluster de machines et ont la possibilité de s’ajuster lorsque de nouvelles machines sont ajoutées ou en cas de panne. La gestion de cluster (la gestion des opérations de données sur un cluster) est un composant important des systèmes de gestion de Big Data actuels.

Remarque :

La sécurité est une mesure de la capacité du système à protéger les données et les informations contre les accès non autorisés tout en fournissant un accès aux personnes et aux systèmes autorisés. Une action entreprise contre un système informatique dans l’intention de nuire est appelée une attaque et peut prendre plusieurs formes. Il peut s’agir d’une tentative non autorisée d’accéder à des données ou à des services ou de modifier des données, ou bien de refuser des services à des utilisateurs légitimes.

L’évolutivité implique l’impact de l’ajout ou de la suppression de ressources, et les mesures refléteront la disponibilité associée et le prêt attribué aux ressources existantes et nouvelles. Bien que de nombreux produits de sécurité soient disponibles, assurer la sécurité tout en assurant l’efficacité du traitement des données reste un sujet de recherche important dans le domaine de la gestion du Big Data.

2.2 Services de gestion de données volumineuses

Il existe différentes variétés de solutions de gestion de Big Data parmi lesquelles les entreprises peuvent choisir. Différents fournisseurs prennent en charge différentes piles technologiques et ont différents modèles de tarification. Certains fournisseurs proposent une variété d’outils de gestion de données volumineuses, autonomes ou multiples. Dans cette section, nous présenterons quelques services de fournisseurs de gestion de données.

2.2.1 Nettoyage des données

Le nettoyage des données est le processus d’identification et de correction des enregistrements corrompus ou erronés dans un jeu, une table ou une base de données. Il traite également de l’identification des parties incomplètes, incorrectes, inexactes ou non pertinentes des données, puis du remplacement, de la modification ou de la suppression des données infectées. La saisie et l’acquisition de données sont par nature sujettes aux erreurs, simples et complexes. Ce processus frontal nécessite beaucoup d’efforts, mais il n’en reste pas moins que les erreurs sont courantes dans les grands ensembles de données. En ce qui concerne la gestion des données volumineuses, le nettoyage des données est très important pour les raisons suivantes :

- Les données principales sont généralement réparties sur différents systèmes hérités, notamment des feuilles de calcul, des fichiers texte et des pages Web.

- En s’assurant que les données sont aussi précises que possible, une organisation peut entretenir de bonnes relations avec ses clients, améliorant ainsi son efficacité.

- Des données correctes et complètes permettent de mieux comprendre le processus concerné par les données.

Il existe des bibliothèques pour Python (Pandas) et R ( Dplyr ) qui peuvent vous aider dans ce processus. En outre, il existe d’autres services haut de gamme disponibles sur le marché, notamment Trifacta , OpenRefine , Paxata , etc.

2.2.2 Intégration de données

Dans un scénario général, les données proviennent de différentes sources. L’intégration des données est l’une des techniques permettant de combiner des données provenant de sources différentes et de fournir aux utilisateurs finaux une vue unifiée de ces données. Cela donne un sentiment d’abstraction aux utilisateurs finaux.

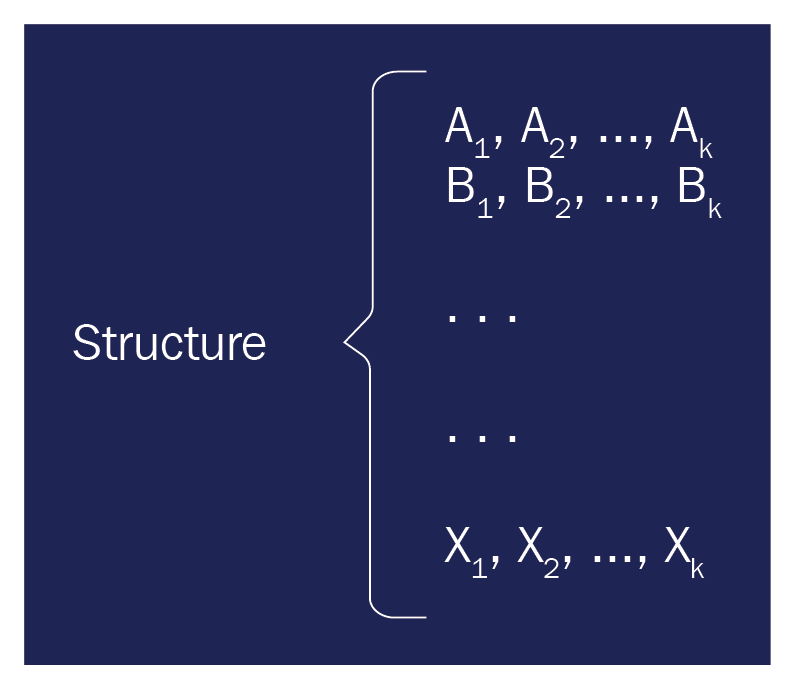

Mathématiquement, les systèmes d’intégration de données sont formellement définis en tant que <G, S, M>:

- G est le schéma global

- S est l’ensemble hétérogène de schémas sources

- M est le mappage qui mappe les requêtes entre les schémas source et global

Les lettres G et S sont exprimées en langues sur des alphabets composés de symboles pour chacune de leurs relations respectives. Le mappage M consiste en des assertions entre les requêtes overG et les requêtes overS.

Il existe quelques autres capacités de gestion de Big Data ; ils peuvent être expliqués comme suit :

- Migration de données : il s’agit du processus de transfert de données d’un environnement à un autre. La plupart des migrations ont lieu entre des ordinateurs et des périphériques de stockage (par exemple, le transfert de données de centres de données internes vers le cloud).

- Préparation des données : les données utilisées pour l’analyse sont souvent salissantes, incohérentes et non normalisées. Ces données doivent être collectées et nettoyées dans un fichier ou une table de données avant qu’une analyse réelle puisse avoir lieu. Cette étape est appelée préparation des données. Cela implique de manipuler des données en désordre, d’essayer de combiner des données provenant de plusieurs sources et de générer des rapports sur les sources de données saisies manuellement.

- Enrichissement des données : cette étape consiste à améliorer l’ensemble de données existant en affinant les données afin d’améliorer leur qualité. Cela peut être fait de plusieurs manières. L’ajout de nouveaux jeux de données, la correction d’erreurs miniatures ou l’extrapolation de nouvelles informations à partir de données brutes sont des méthodes courantes.

- Analyse de données : il s’agit de tirer des informations des jeux de données en les analysant à l’aide de divers algorithmes. La plupart des étapes sont automatisées à l’aide de divers outils.

- Qualité des données : Il s’agit de confirmer que les données sont exactes et fiables. La qualité des données est contrôlée de plusieurs manières.

- Master Data Management (MDM) : il s’agit d’une méthode utilisée pour définir et gérer les données importantes de toute entreprise, afin de faciliter le processus de liaison des données d’entreprise critiques à un seul ensemble principal. L’ensemble principal fonctionne comme une source unique de vérité pour l’organisation.

- Gouvernance des données : il s’agit d’un concept de gestion des données qui traite de la capacité d’une entreprise à garantir une qualité élevée des données tout au long du processus d’analyse. Ce processus consiste notamment à garantir la disponibilité, la convivialité, l’intégrité et la précision des données.

- Extraction de la charge de transformation (ETL) : comme son nom l’indique, il s’agit du processus de déplacement de données d’un référentiel existant vers une autre base de données ou un nouvel entrepôt de données.

2.3 Fournisseurs de gestion de données volumineuses

En raison de la forte prévalence du big data et de son utilisation dans la veille stratégique, il existe des milliers de fournisseurs de gestion de big data sur le marché, prêts à fournir tous les services de gestion de données. Passer par chacun d’eux irait au-delà de la portée de l’article. Dans cette section, nous allons explorer dix fournisseurs de solutions Big Data. La liste contenue dans cet article ne garantit pas la popularité ou les performances de chaque fournisseur. La liste a été créée sur la base de l’analyse de données effectuée :

- Alation : Alation est une organisation plus récente qui fournit des services de données dans le cloud, créés pour centraliser les connaissances sur les données d’une entreprise et sur la manière de les appliquer. Pour en savoir plus sur la société, cliquez sur le lien fourni dans la section Études complémentaires.

- AtScale : AtScale fournit une technologie facilitant l’utilisation d’outils de BI familiers pour interroger les données stockées dans Hadoop.

- Cloudera : Cloudera est l’une des trois principales organisations de distribution Hadoop. Il fournit sa propre pile de technologies analytiques et de gestion de Big Data Open Source aux entreprises. Intel conserve une grande participation dans la société.

- Collibra : Collibra fournit aux organisations prenant en charge l’automatisation des processus de gestion de données fonctionnant des initiatives de qualité des données, de gestion des données principales et de gestion des métadonnées.

- Confluent : Confluent est le créateur et le distributeur d’Apache Kafka, une technologie Big Data en temps réel qui fonctionne comme un système de messagerie qui permet aux environnements d’applications et de données complexes. Cette société est incubée dans LinkedIn.

- Hortonworks : Hortonworks est l’un des trois principaux fournisseurs de la distribution Hadoop et est à la base de l’initiative Open Data Platform ( ODPi ). Une partie de son financement initial provenait de la société d’incubateur Hadoop Yahoo.

- SAS : SAS est un géant de l’analyse populaire. Il fournit également une solution de gestion de données maîtresses destinée à aider les entreprises à préparer et à gérer les sources de données traditionnelles et les sources de données volumineuses.

- Verato : Verato fournit une plate-forme basée sur le cloud qui a été inventée pour maintenir des données d’identité nettes sur plusieurs systèmes de données, en s’assurant que les nouvelles données qui entrent dans le système sont précises et en reliant les enregistrements entre systèmes et au sein des entreprises.

- TIBCO : TIBCO propose des logiciels d’intégration, d’analyse et de traitement des événements destinés aux entreprises et autres organisations.

- Talend : La vision de la plate-forme unifiée de Talend fournit des capacités multi-domaines (MDM), de qualité des données et d’intégration. La société a ses racines dans le concept open source.

2.4 Stockage de données volumineuses et modèles de données

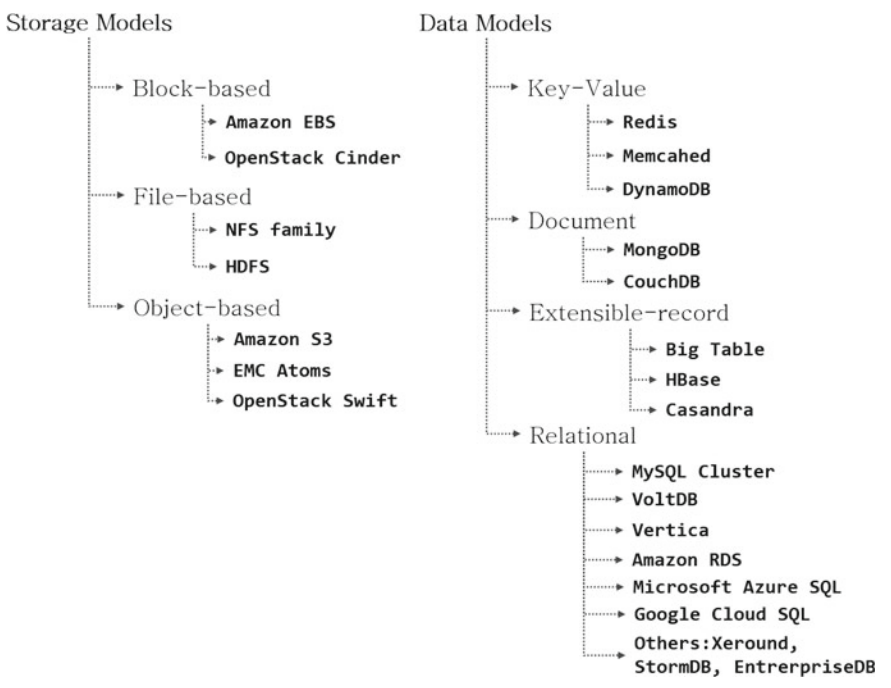

Nous avons maintenant exploré ce qu’est le big data, ainsi que son importance. La demande de stockage et de traitement d’ensembles de données à grande échelle a favorisé le développement de systèmes de stockage de données et de bases de données au cours des dernières années. Avec cette avancée, les systèmes de stockage et les modèles de données pour les mégadonnées ont été améliorés au fil du temps, du stockage local au stockage en cluster, distribué au stockage en nuage. Dans cette section, vous découvrirez certains des modèles de stockage et modèles de données les plus populaires :

Le diagramme précédent montre la taxonomie des magasins de données et des plates-formes de données, ainsi que les systèmes correspondants actuellement disponibles sur le marché. Explorons chaque catégorie dans la section suivante.

2.4.1 Modèles de stockage

Le modèle de stockage est le composant essentiel des systèmes Big Data. Ces modèles ont un impact sur l’évolutivité, la programmation, les structures de données et les modèles informatiques du système. Dans la section suivante, nous allons explorer trois types de modèles de stockage courants : le stockage basé sur le blocage, le stockage basé sur le fichier et le stockage basé sur les objets.

2.4.1.1 Stockage par blocs (Block based)

Dans un modèle de stockage basé sur des blocs, vous rencontrez un système similaire à un modèle de stockage traditionnel, avec une capacité de stockage brute de taille fixe, tout comme le disque dur d’un serveur. Ici, le disque dur peut être installé sur un serveur distant. C’est le concept principal des systèmes de stockage basés sur des blocs.

Chaque bloc de stockage peut être traité comme un lecteur de disque indépendant et peut également être contrôlé par un système d’exploitation externe. Certains systèmes de stockage classiques basés sur des blocs sont les suivants :

- AmazonElastic BlockStore (Amazon EBS) est un service de stockage de niveau bloc

- OpenStack est fourni par le système Nova

2.4.1.2 Stockage sur fichier

Le stockage sur fichier est le modèle de stockage le plus courant et présente des avantages par rapport à d’autres modèles de stockage, en termes de facilité d’utilisation et de simplicité. Il étend l’architecture de système de fichiers traditionnelle en conservant les données dans une structure hiérarchique sous forme de fichiers. En conséquence, ce type de stockage comporte des chemins de fichiers hiérarchisés, utilisés comme entrées pour accéder aux données du stockage physique. Le Big Data utilise couramment les systèmes de fichiers distribués (DFS) comme système de stockage de base. Les utilisateurs ont besoin d’espaces de noms et de connaissances sur les chemins d’accès pour accéder aux fichiers enregistrés dans un stockage basé sur fichiers. Pour le partage de fichiers inter système, le chemin ou l’espace de nom d’un fichier se compose de trois parties principales : le protocole, le nom de domaine et le chemin du fichier. La famille NFS et HDFS sont deux modèles de stockage courants basés sur des fichiers, définis comme suit :

- Famille NFS : Il s’agit d’un protocole de système de fichiers distribué, initialement créé par Sun Microsystems. Dans ce système, un système de fichiers réseau (NFS) permet aux hôtes distants de monter des systèmes de fichiers sur un réseau et d’interagir avec ces systèmes de fichiers comme s’ils étaient montés localement. NFS a été largement utilisé dans les systèmes d’exploitation Unix et Linux, et a également encouragé le développement de systèmes de fichiers distribués modernes.

- HDFS : Le système de fichiers distribués Hadoop (HDFS) est un système de fichiers distribué créé et optimisé pour le traitement de gros volumes de données et pour une disponibilité accrue. Il se propage sur le stockage local d’un cluster composé de nombreux nœuds de serveur. HDFS est un système de fichiers distribué open source, écrit en Java. Il s’agit de l’implémentation open-source du système de fichiers Google (GFS) et constitue le stockage principal des écosystèmes Hadoop et de la majorité des plates-formes Big Data existantes. HDFS a été conçu pour la détection et la récupération d’erreur, et est capable de gérer d’énormes jeux de données.

2.4.1.3 Stockage basé sur les objets

Les modèles de stockage basés sur les objets gèrent les données en tant qu’objets. Ils peuvent être implémentés à différents niveaux, y compris les niveaux de périphérique, de système et d’interface. Le système de stockage basé sur les objets utilise un espace de noms plat, qui conserve généralement les identificateurs de données et leurs emplacements sous forme de paires clé-valeur dans le serveur d’objets. L’architecture plate simplifie la mise à l’échelle des systèmes de stockage basés sur des objets en offrant la possibilité d’ajouter des nœuds de stockage supplémentaires au système.

Il existe un certain nombre de solutions de stockage basées sur des objets, comme suit :

- Amazon S3 (Simple Storage Service) est une solution en nuage proposée par Amazon Web Services (AWS).

- EMC Atmos est une plate-forme de services de stockage sur objets développée par EMC Corporation.

- OpenStack Swift est un système de stockage évolutif, redondant et distribué basé sur des objets qui fonctionne sur la plate-forme en nuage OpenStack.

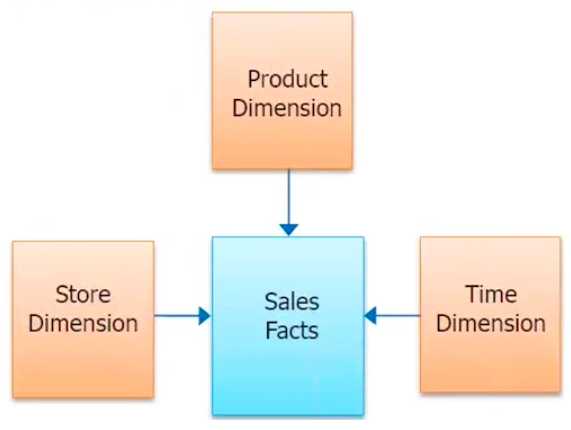

2.4.2 Modèles de données

Un modèle de données détermine la manière dont vous pouvez organiser et structurer les éléments de données. Les modèles de données constituent le cœur du stockage des données, de l’analyse et du traitement des systèmes Big Data contemporains. En général, les modèles de données peuvent être classés en deux grandes familles, qui seront décrites dans les sections suivantes.

2.4.2.1 Magasins relationnels (SQL)

MySQL, Oracle, SQL Server, PostgreSQL, etc., sont quelques systèmes de gestion de base de données relationnelle (SGBDR) qui ont dominé la communauté des bases de données pendant des décennies, jusqu’à ce qu’ils soient confrontés à la limitation de la mise à l’échelle pour des jeux de données à très grande échelle. Certaines propriétés de base de données importantes que suivent les bases de données relationnelles sont l’atomicité, la cohérence, l’isolation et la durabilité (ACID). Les magasins relationnels peuvent être classés en deux grandes familles :

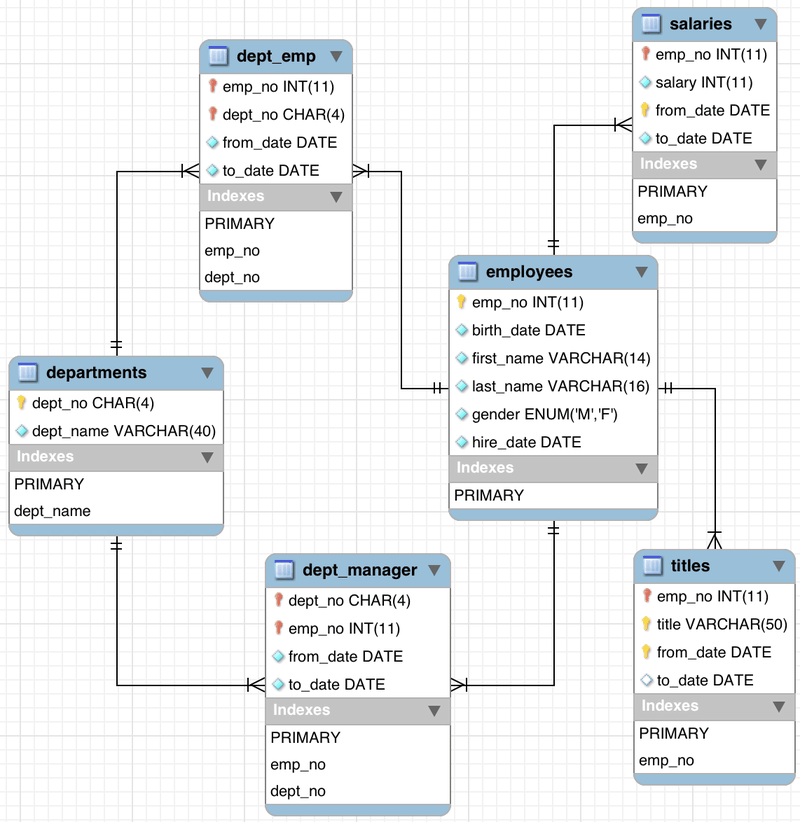

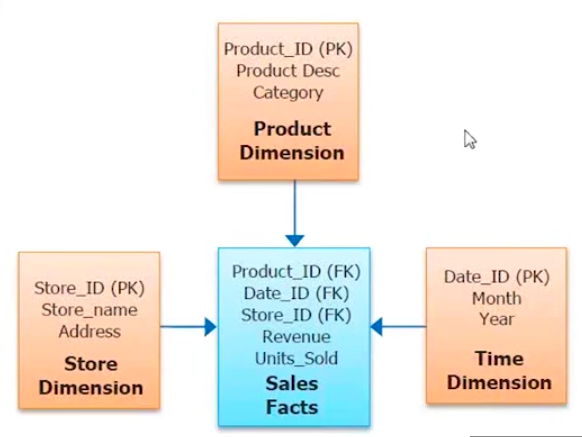

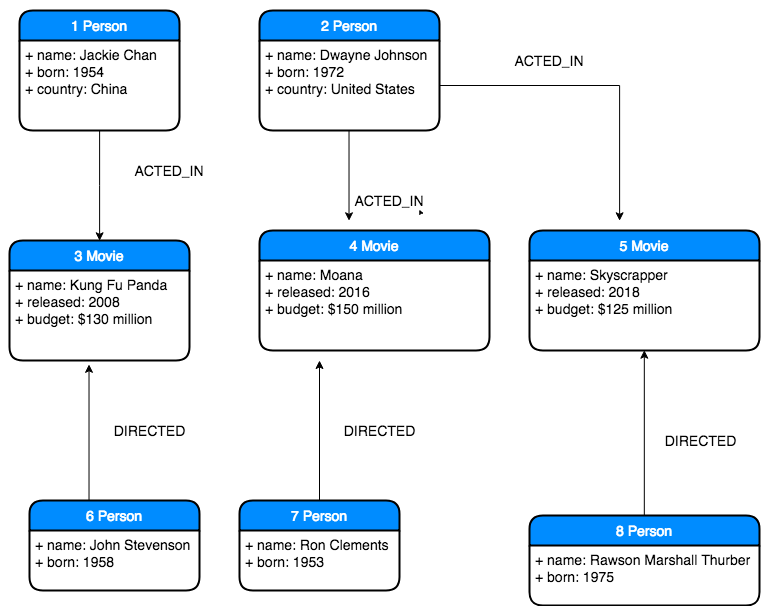

La figure illustre la manière dont les informations d’un service peuvent être stockées et leur relation. Le diagramme illustre clairement la relation qui est établie entre chacune des tables. Par exemple, la table des employés stocke le numéro d’employé comme identifiant, la date de naissance, le prénom, le nom de famille, le sexe et la date d’embauche. Les salaires des employés correspondants sont stockés dans la table des salaires.

2.4.2.2 Systèmes relationnels évolutifs

Les systèmes relationnels évolutifs présentent des améliorations par rapport aux SGBD traditionnels, afin de faire face aux performances et à l’évolutivité. Voici quelques systèmes relationnels évolutifs majeurs :

- MySQL Cluster : MySQL Cluster fait partie des principales versions de MySQL. Il s’agit d’une extension qui prend en charge les bases de données distribuées, multi-maîtres et compatibles ACID.

- VoltDB : VoltDB est une base de données en mémoire open source, basée sur SQL, conçue pour des performances élevées, ainsi que pour son évolutivité.

- Vertica Analytics Platform : Vertica Analytics Platform est un système de gestion de base de données répartie basé sur le cloud, orienté colonne.

2.4.2.3 Base de données en tant que service ( DaaS )

Base de données en tant que service ( DaaS ) est un modèle de service dans lequel un fournisseur de services tiers, qui héberge des bases de données relationnelles évolutives en tant que services, applique la technologie multi-tenants aux systèmes de base de données. Voici quelques exemples célèbres :

- Amazon RDS : Amazon RDS (service de base de données relationnelle) est un service DaaS fourni par AWS. Amazone RDS offre une capacité rentable et redimensionnable, tout en automatisant des tâches d’administration fastidieuses, telles que le provisionnement du matériel, la configuration de la base de données, les correctifs et les sauvegardes. Il permet aux utilisateurs de se concentrer sur leurs applications afin de bénéficier des performances rapides, de la haute disponibilité, de la sécurité et de la compatibilité dont ils ont besoin.

- Microsoft Azure SQL : Azure [16] est un ensemble complet de services de cloud computing que les développeurs et les professionnels de l’informatique utilisent pour créer, déployer et gérer des applications via le réseau mondial de centres de données. Le système comprend des outils intégrés, des DevOps et une assistance sur le marché qui permettent de créer efficacement des applications mobiles allant des simples applications mobiles aux solutions à l’échelle Internet.

- Google Cloud SQL : Cloud SQL est un service de base de données entièrement géré. Il est facile de configurer, gérer, gérer et administrer des bases de données relationnelles dans le cloud. Les utilisateurs peuvent utiliser Cloud SQL avec MySQL ou PostgreSQL. En plus de cela, Cloud SQL offre une évolutivité, des performances, une sécurité et une commodité élevées.

- StormDB : StormDB fournit une base de données en tant que plate-forme de nuage de services pouvant gérer de manière unique des charges de travail transactionnelles intensives en temps réel.

- Autres ( EnterpriseDB , Xeround ).

2.4.3 Magasins NoSQL

La plupart des systèmes NoSQL présentent les fonctionnalités suivantes :

- Grande évolutivité

- Haute disponibilité

- Haute tolérance aux pannes

- Flexibilité dans les modèles de données

- Modèles de cohérence plus faibles ayant abandonné les transactions ACID

- Interfaces simples

Explorons certains systèmes NoSQL dans les sections suivantes.

2.4.3.1 Magasins de documents

Dans les magasins de documents, les données sont enregistrées dans des documents. Semblables aux magasins de clés-valeurs, les documents (valeurs) sont référencés par des noms uniques (clés). Chaque document est totalement libre en ce qui concerne son schéma ; En d’autres termes, vous pouvez utiliser le schéma requis par l’application. Si la demande évolue, les adaptations sont plutôt simples. De nouveaux champs peuvent être attachés et les champs utilisés peuvent être éliminés.

MongoDB : Comme le prétend la communauté, MongoDB est une base de données polyvalente solide, flexible et évolutive. Il associe la possibilité d’évoluer avec des fonctionnalités telles que les index secondaires, les requêtes d’intervalle, le tri, les agrégations et les index géospatiaux. MongoDB est une base de données orientée document, et non relationnelle, qui présente des avantages faciles à utiliser.

MongoDB a été conçu pour être évolutif. Il garantit de hautes performances, une haute disponibilité et une mise à l’échelle automatique. S’agissant d’un modèle de données orienté document, il est plus facile de fractionner les données sur plusieurs serveurs géographiquement situés à des emplacements distincts. Le composant d’équilibrage de charge de MongoDB équilibre automatiquement les données et la charge entre les clusters et redistribue automatiquement les documents correspondants, le routage des lectures et des écritures sur les machines appropriées.

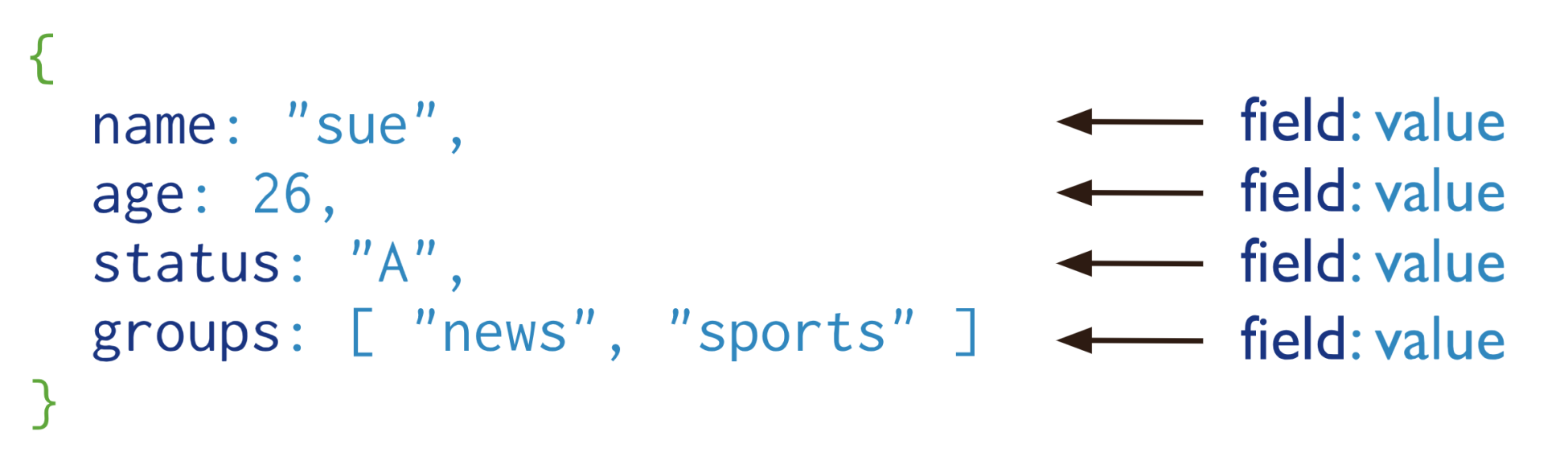

Un enregistrement dans MongoDB est appelé un document, qui est une structure de données composée de paires de champs et de valeurs. Les documents MongoDB sont très similaires aux objets JSON. Les valeurs des champs peuvent inclure d’autres documents, tableaux et tableaux de documents. Un exemple de document MongoDB est donné dans la capture d’écran suivante, qui montre un seul objet comportant un champ et une valeur. Par exemple, name est le champ et sue est la valeur correspondante. L’objet appartient à une seule personne dont le nom est sue, qui a 26 ans, qui a la valeur de status A et qui est abonnée aux groups de news et de sports :

Voici quelques caractéristiques notables de MongoDB :

- Il offre une persistance des données hautes performances et prend en charge un modèle de données intégré qui réduit l’activité d’E / S sur le système de base de données.

- Il prend en charge un langage RQL (Rich Query Language), notamment l’agrégation de données, la recherche de texte et les requêtes géospatiales.

- La fonction de réplication de MongoDB, appelée ensemble de réplicas, fournit un basculement automatique et une redondance des données. Un jeu de réplicas est un groupe de serveurs MongoDB qui conserve le même jeu de données, offrant une redondance et une disponibilité accrue des données.

- MongoDB offre une évolutivité horizontale dans le cadre de ses fonctionnalités principales.

- Il prend en charge plusieurs moteurs de stockage, dont WiredTiger Storage Engine, In-Memory Storage Engine et MMAPv1 Storage Engine.

CouchDB: CouchDB est une base de données qui englobe complètement le Web. Il stocke des données avec des documents JSON et permet d’accéder à des documents avec un navigateur Web, via HTTP. CouchDB fonctionne bien avec les applications Web et mobiles modernes. Nous pouvons distribuer nos données efficacement en utilisant la réplication incrémentielle de CouchDB. CouchDB prend en charge les configurations maître-maître, avec détection automatique des conflits :

- Les requêtes sur les documents CouchDB sont appelées vues. Il s’agit de fonctions JavaScript basées sur MapReduce spécifiant des contraintes de correspondance et une logique d’agrégation.

- CouchDB prend également en charge les verrouillages optimistes basés sur le contrôle MVCC (Multi-Versioned Concurrency Control), ce qui lui permet de ne pas être verrouillés lors des opérations de lecture.

2.4.3.2 Magasins de clés-valeur

Les magasins de clés-valeurs utilisent un modèle de données simple dans lequel les données sont considérées comme une paire définie de clés-valeurs ; les clés sont des identifiants uniques pour chaque donnée et servent également d’index lors de l’accès aux données :

- Serveur de dictionnaire distant (Redis) : La popularité croissante de Redis, une technologie NoSQL Open Source clé-valeur, résulte de la stabilité, de la puissance et de la flexibilité de Redis dans l’exécution d’un large éventail d’opérations et de tâches dans l’entreprise. Redis est utilisé par un ensemble varié de sociétés, des startups aux plus grandes sociétés de technologie. Il est écrit en C. Redis vous permet de conceptualiser et d’aborder de manière très différente les problèmes difficiles d’analyse et de manipulation des données, par rapport à un modèle de données relationnel typique. Dans une base de données relationnelle basée sur SQL, le développeur ou l’administration de la base de données crée un schéma de base de données qui organise le domaine de la solution en normalisant les données en colonnes, en lignes et en tables avec des jointures de connexion, via des relations de clé étrangère.

- DynamoDB : DynamoDB est un service de magasin NoSQL fourni par Amazon. Dynamo prend en charge un modèle de données beaucoup plus flexible, en particulier pour les magasins de valeurs clés. Les données dans Dynamo sont stockées dans des tables, chacune ayant un identifiant principal unique d’accès. Chaque table peut avoir un ensemble d’attributs sans schéma, et les types et ensembles scalaires sont pris en charge. Les données de Dynamo peuvent être manipulées en recherchant, en insérant et en supprimant des clés primaires. En outre, les opérations conditionnelles, la modification atomique et la recherche par attributs non clés sont également prises en charge (mais sont inefficaces), ce qui le rapproche également du magasin de documents. Dynamo fournit une architecture rapide et évolutive, dans laquelle le découpage et la réplication sont automatiquement effectués. En outre, Dynamo prend en charge à la fois la cohérence éventuelle et la cohérence élevée des lectures, tandis que la cohérence constante dégrade les performances.

2.4.3.3 Magasins de colonnes (extensible-record)

Les magasins de disques extensibles (également appelés magasins de colonnes) étaient initialement motivés par le projet Big Table de Google. Dans le système, les données sont prises en compte dans les tables avec les familles de lignes et de colonnes, dans lesquelles les lignes et les colonnes peuvent être réparties sur plusieurs nœuds :

- BigTable : Big Table a été introduit par Google en 2004 en tant que magasin de colonnes pour prendre en charge divers services Google. Big Table est construit sur le système de fichiers Google (GFS) et peut facilement être étendu à des centaines et des milliers de nœuds, en maintenant l’échelle de données en téraoctets et en pétaoctets.

- HBase : HBase est un projet open source Apache et a été développé en Java, basé sur les principes de BigTable de Google. HBase est construit sur le cadre Hadoop et Apache Zookeeper, dans orderto fournir une base de données colonne magasin. Comme HBase a été hérité de BigTable , ils partagent de nombreuses fonctionnalités, à la fois dans leurs modèles de données et leurs architectures.

- Cassandra : Cassandra est une base de données NoSQL open source initialement développée par Facebook, en Java. Il combine les idées de BigTable et de Dynamo. Il est maintenant open source sous licence Apache. Casandra partage la majorité de ses fonctionnalités avec d’autres magasins de disques extensibles (magasins de colonnes), à la fois en termes de modélisation de données et de fonctionnalités.

2.5 Modèles de programmation Big Data

Les modèles de programmation Big Data décrivent le style et le paradigme de l’interface permettant aux développeurs d’écrire des applications et des programmes Big Data. Les modèles de programmation sont généralement la caractéristique principale des frameworks Big Data, dans la mesure où ils affectent implicitement le modèle d’exécution des moteurs de traitement Big Data, ainsi que la visualisation et la construction d’applications et de programmes Big Data.

Dans cette section, nous discuterons et comparerons les principaux modèles de programmation pour l’écriture d’applications Big Data, en fonction de leur taxonomie.

2.5.1 MapReduce

MapReduce fait référence à un modèle de programmation adapté au traitement de grandes quantités de données. Par exemple, Hadoop est capable d’exécuter un programme MapReduce écrit dans plusieurs langages de programmation, notamment Java, C ++, Python, Ruby et autres. MapReduce est conçu pour traiter efficacement un grand volume de données, en connectant plusieurs ordinateurs standard, afin de fonctionner en parallèle. En plus de cela, MapReduce réunit des machines plus petites et plus abordables dans un seul groupe de produits rentables. MapReduce atteint cette efficacité en divisant une tâche en plusieurs parties et en les affectant à plusieurs ordinateurs. Plus tard, les résultats sont collectés dans un seul endroit et intégrés, afin de former le jeu de données résultant.

2.5.1.1 Fonctionnalité MapReduce

Tous les programmes / modules MapReduce fonctionnent en deux phases, comme suit:

- Phase de la carte : C’est la première phase. En phase de mappage, un ensemble de données est converti en un autre ensemble de données, dans lequel des éléments individuels sont divisés en tuples (paires clé-valeur).

- Phase de réduction : Il s’agit de la deuxième phase, dans laquelle la sortie de la phase de carte est prise en entrée et fusionne les nuplets de données en un plus petit ensemble de nuplets.

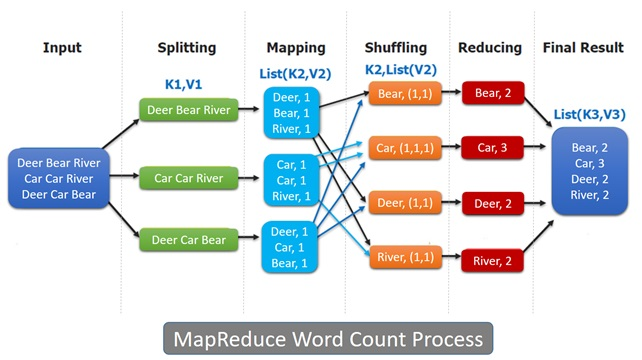

Il existe un JobTracker qui divise un problème donné en plusieurs tâches de mappage. Ces tâches sont réparties sur le réseau vers un certain nombre de nœuds esclaves, pour un traitement en parallèle. Ces nœuds esclaves sont appelés TaskTrackers. En règle générale, les tâches de mappage fonctionnent sur les mêmes nœuds de cluster, où les données traitées restent. Si ce nœud de serveur est déjà lourdement chargé, un autre nœud proche des données sera choisi. Examinons le processus de travail de MapReduce, comme indiqué dans le diagramme suivant :

Le diagramme précédent montre un bref aperçu du fonctionnement de l’algorithme MapReduce. Il y a différentes phases impliquées. En supposant que le programme MapReduce ait à résoudre un problème, celui-ci doit s’exécuter dans l’ordre indiqué sur la figure. Inspectons chaque phase en détail, comme suit :

- Phase d’entrée : lors de la phase d’entrée, un lecteur d’enregistrement interprète chaque enregistrement dans un fichier d’entrée et envoie les données analysées au mappeur, sous la forme de paires clé-valeur. C’est la première étape du module MapReduce.

- Mappeur : un mappeur est un module de programme défini par l’utilisateur qui utilise une série de paires clé-valeur et traite chacune d’elles afin de générer des paires clé-valeur traitées en sortie.

- Clés intermédiaires : le mappeur utilise les paires clé-valeur et génère les paires clé-valeur traitées. Les paires clé-valeur générées par les mappeurs sont appelées clés intermédiaires.

- Combinateur : il existe un réducteur local qui regroupe des données similaires du mappeur en ensembles identifiables. Ils sont souvent appelés un combinateur. Il s’agit d’une phase facultative pouvant être présente ou non dans un sous-programme MapReduce particulier.

- Mélanger et trier : dans la phase de mélange et de tri, la sortie de la phase de mappeur est consommée en tant qu’entrée. Il y a généralement une grande quantité de données intermédiaires à déplacer de tous les nœuds de la carte vers tous les nœuds de réduction de la phase de lecture aléatoire. La phase de lecture aléatoire transfère les données des disques du mappeur, plutôt que de leurs mémoires principales, et la sortie intermédiaire sera triée par clés, de sorte que toutes les paires contenant les mêmes clés seront regroupées. Les données des nœuds de carte locaux sont transférées aux nœuds de réduction via le réseau.

- Réducteur : le réducteur utilise en entrée les données de pair clé-valeur groupées et exécute une fonction de réduction sur chaque paire. Il y a zéro ou plusieurs paires clé-valeur en sortie de la fonction de réduction. Cette sortie est redirigée vers la dernière étape du module MapReduce.

- Phase de sortie : Il existe un formateur de sortie qui traduit les dernières paires clé-valeur à partir de la fonction de réduction et les écrit dans un fichier à l’aide d’un graveur d’enregistrement. Le fichier de sortie contient la sortie finale du sous-programme.

2.5.1.2 Hadoop

Hadoop est très populaire dans l’écosystème du Big Data. Il est basé sur un modèle de structure de logiciel open source. Hadoop est connu pour stocker des données et exécuter des applications sur des grappes de matériel de base. Il a évolué au début des années 2000. Il garantit un stockage massif pour tout type de données, une puissance de traitement énorme et la capacité de gérer des tâches simultanées pratiquement illimitées. De plus, les technologies et les langages utilisés dans l’écosystème Hadoop sont bien connus dans la communauté.

2.5.1.3 Caractéristiques des frameworks Hadoop

Certaines fonctionnalités importantes des plates-formes Hadoop sont résumées comme suit: